Britische Gesetzgeber warnen: KI-Sicherheitsversprechen werden zur bloßen Augenwischerei

- 60 britische Abgeordnete beschuldigen Google DeepMind, gegen KI-Sicherheitszusagen verstoßen zu haben, indem detaillierte Sicherheitsberichte für Gemini 2.5 Pro verzögert wurden. - Das Unternehmen veröffentlichte drei Wochen nach dem Start eine vereinfachte Modellkarte, die keine Transparenz hinsichtlich Tests durch Dritte und der Beteiligung von Regierungsbehörden bietet. - Google behauptet, seine Zusagen durch die Veröffentlichung eines technischen Berichts Monate später eingehalten zu haben, doch Kritiker argumentieren, dass dies das Vertrauen in die Sicherheitsprotokolle untergräbt. - Ähnliche Probleme bei Meta und OpenAI verdeutlichen branchenweite Bedenken hinsichtlich der Transparenz.

Eine Gruppe von 60 britischen Abgeordneten hat einen offenen Brief unterzeichnet, in dem sie Google DeepMind beschuldigt, seine Verpflichtungen zur KI-Sicherheit nicht einzuhalten, insbesondere im Hinblick auf die verzögerte Veröffentlichung detaillierter Sicherheitsinformationen für das Gemini 2.5 Pro-Modell [1]. Der Brief, veröffentlicht von der politischen Aktivistengruppe PauseAI, kritisiert das Unternehmen dafür, dass es zum Zeitpunkt der Veröffentlichung des Modells keine umfassende Model Card bereitgestellt hat – ein zentrales Dokument, das beschreibt, wie das Modell getestet und entwickelt wurde [1]. Dieses Versäumnis stelle, so die Unterzeichner, einen Verstoß gegen die Frontier AI Safety Commitments dar, die auf einem internationalen Gipfel im Februar 2024 eingegangen wurden. Zu den Unterzeichnern gehörte auch Google, das sich verpflichtete, öffentlich über Modellfähigkeiten, Risikobewertungen und die Beteiligung Dritter an Tests zu berichten [1].

Google veröffentlichte Gemini 2.5 Pro im März 2025, stellte jedoch zu diesem Zeitpunkt keine vollständige Model Card zur Verfügung, obwohl behauptet wurde, das Modell übertreffe die Konkurrenz bei wichtigen Benchmarks [1]. Stattdessen wurde drei Wochen später eine vereinfachte Model Card mit sechs Seiten veröffentlicht, die von einigen Experten für KI-Governance als unzureichend und besorgniserregend bezeichnet wurde [1]. Der Brief hebt hervor, dass das Dokument keine wesentlichen Details zu externen Bewertungen enthielt und nicht bestätigte, ob Regierungsbehörden wie das U.K. AI Security Institute an den Tests beteiligt waren [1]. Diese Auslassungen werfen Bedenken hinsichtlich der Transparenz der Sicherheitspraktiken des Unternehmens auf.

Als Reaktion auf die Kritik erklärte ein Google DeepMind-Sprecher zuvor gegenüber Fortune, dass jeder Hinweis darauf, das Unternehmen würde seine Verpflichtungen nicht einhalten, "unzutreffend" sei [1]. Das Unternehmen erklärte außerdem im Mai, dass ein detaillierterer technischer Bericht veröffentlicht werde, sobald die endgültige Version der Gemini 2.5 Pro-Modellfamilie verfügbar sei. Ein umfassenderer Bericht wurde schließlich Ende Juni veröffentlicht, Monate nachdem die vollständige Version verfügbar war [1]. Der Sprecher bekräftigte, dass das Unternehmen seine öffentlichen Verpflichtungen, einschließlich der Seoul Frontier AI Safety Commitments, erfülle und dass Gemini 2.5 Pro strengen Sicherheitsprüfungen unterzogen worden sei, einschließlich Bewertungen durch unabhängige Dritte [1].

Der Brief weist außerdem darauf hin, dass die fehlende Model Card für Gemini 2.5 Pro anderen Zusagen von Google zu widersprechen scheint, wie den White House Commitments von 2023 und einem freiwilligen Code of Conduct on Artificial Intelligence, der im Oktober 2023 unterzeichnet wurde [1]. Die Situation ist nicht einzigartig für Google. Auch Meta wurde für seine minimale und eingeschränkte Model Card für das Llama 4-Modell kritisiert, während OpenAI sich entschied, keinen Sicherheitsbericht für sein GPT-4.1-Modell zu veröffentlichen, da es nicht als Frontier-Modell eingestuft wurde [1]. Diese Entwicklungen deuten auf einen breiteren Trend in der Branche hin, bei dem Sicherheitsangaben weniger transparent gemacht oder ganz weggelassen werden.

Der Brief fordert Google auf, seine Verpflichtungen zur KI-Sicherheit zu bekräftigen, indem der Zeitpunkt der Bereitstellung klar als der Moment definiert wird, in dem ein Modell öffentlich zugänglich wird, und indem zugesichert wird, Sicherheitsbewertungsberichte für alle zukünftigen Modellveröffentlichungen nach einem festen Zeitplan zu veröffentlichen. Zudem wird volle Transparenz für jede Veröffentlichung gefordert, einschließlich der Nennung der beteiligten Regierungsbehörden und unabhängigen Dritten sowie der genauen Testzeiträume [1]. Lord Browne of Ladyton, ein Unterzeichner des Briefes und Mitglied des House of Lords, warnte, dass es zu einem gefährlichen Wettlauf um die Einführung immer leistungsfähigerer KI-Systeme ohne angemessene Schutzmaßnahmen kommen könnte, wenn führende KI-Unternehmen Sicherheitsverpflichtungen als optional betrachten [1].

Quelle:

Haftungsausschluss: Der Inhalt dieses Artikels gibt ausschließlich die Meinung des Autors wieder und repräsentiert nicht die Plattform in irgendeiner Form. Dieser Artikel ist nicht dazu gedacht, als Referenz für Investitionsentscheidungen zu dienen.

Das könnte Ihnen auch gefallen

Kalshi-Händler bewerten die rückläufigen Chancen auf eine Bitcoin-Erholung auf 100.000 Dollar im Jahr 2025

Die Prognosemärkte wurden vorsichtiger, obwohl der Bitcoin-Preis sich um 17 % von den Kapitulationstiefs der letzten Woche erholte und die ETF-Zuflüsse keinen entscheidenden Ausbruch auslösen konnten.

ADA steht vor einer Verkaufswand von 40 Millionen Dollar, während der Budgetantrag des Teams über 70 Millionen ADA eine Zustimmung von 53 % überschreitet

Der Cardano-Preis stabilisierte sich am 29. November knapp über $0,41, als eine Governance-Abstimmung über die Zuteilung eines Budgets von 70 Millionen ADA die Mehrheit erhielt, während neue Derivatedaten eine kritische Widerstandsbarriere bei etwa $0,44 zeigten.

Solana-Bullen erhöhen den Hebel, während der Rückzug des 21Shares ETF kurzzeitige Volatilität auslöst

Der Solana-Preis stabilisierte sich diese Woche über 135 $, da bullische gehebelte Trader die ETF-bedingten Gegenwinde absorbierten und das Vertrauen an den Derivatemärkten wiederherstellten.

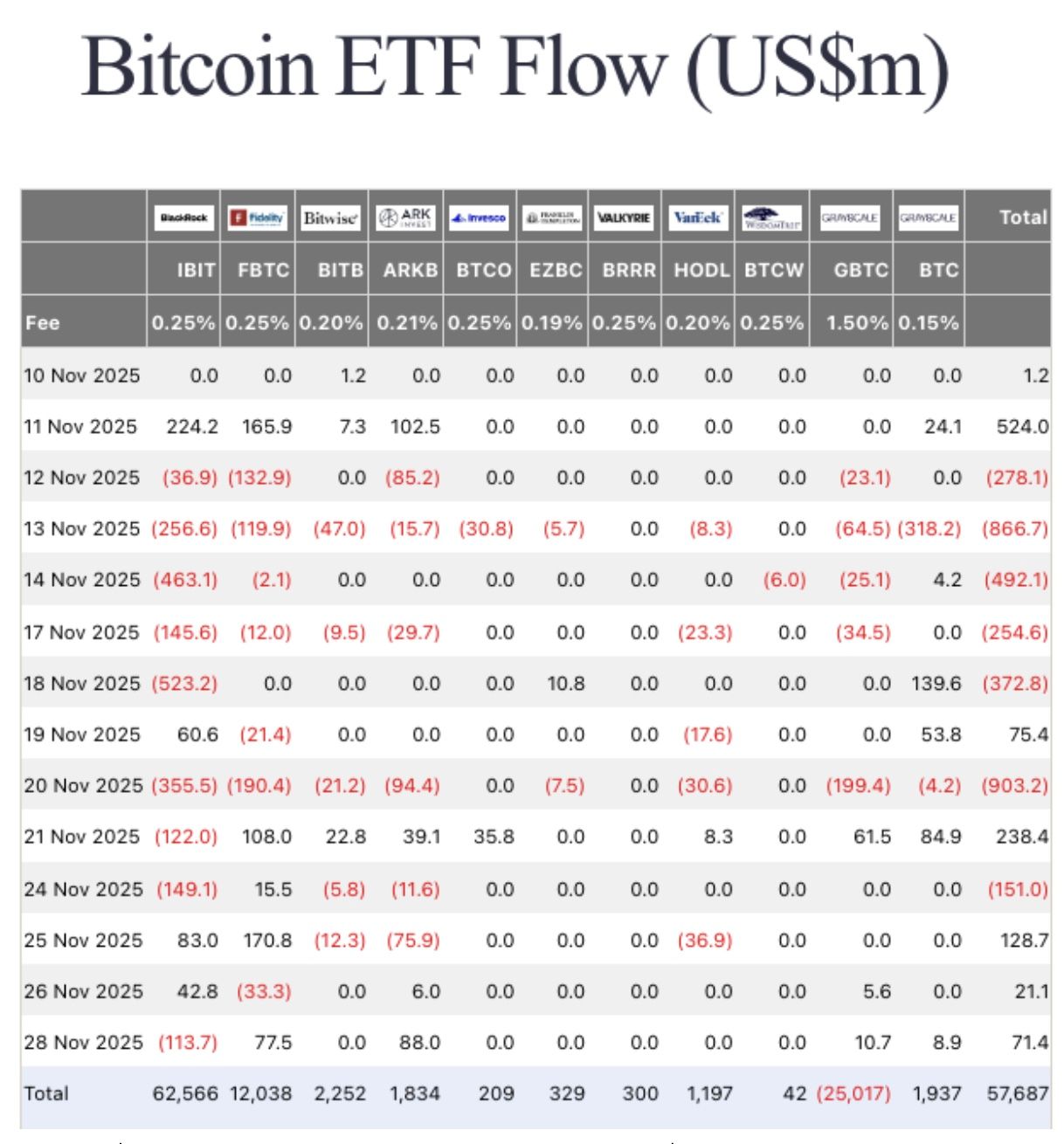

Spot-Bitcoin- und Ether-ETFs gewinnen wieder an Schwung mit der ersten Woche mit Nettozuflüssen seit Oktober

Kurze Zusammenfassung: Die US-amerikanischen Spot-Bitcoin- und Ethereum-ETFs verzeichneten diese Woche, die aufgrund des Thanksgiving-Feiertags verkürzt war, erstmals seit Ende Oktober wieder Nettozuflüsse. Die Bitcoin-ETFs verzeichneten Zuflüsse in Höhe von 70 Millionen US-Dollar und durchbrachen damit eine vierwöchige Nettoabflussserie mit Abflüssen von über 4.3 Milliarden US-Dollar. Die Ethereum-ETFs verzeichneten Zuflüsse in Höhe von 313 Millionen US-Dollar und beendeten damit ihre eigene dreitägige Abflussserie von insgesamt 1.7 Milliarden US-Dollar. Die Spot-Solana-ETFs, die am Mittwoch eine 21-tägige Zuflussserie mit Abflüssen unterbrachen, verzeichneten...