Metas KI-Wächter: Echtzeit-Schutz gegen digitale Gefahren für Jugendliche

- Meta führt KI-Chatbots ein, um schädliche Inhalte und verdächtige Interaktionen auf seinen Plattformen zu überwachen, wobei der Schwerpunkt auf dem Schutz von Jugendlichen durch die Echtzeiterkennung von Cybermobbing, Anbahnung und unangemessenen Materialien liegt. - Die KI nutzt NLP und Verhaltensanalysen, um Risiken zu kennzeichnen, ohne die Privatsphäre zu verletzen, und ermöglicht es Jugendlichen, Datenschutzeinstellungen individuell anzupassen, wobei ein Gleichgewicht zwischen Sicherheit und Autonomie gewahrt bleibt. - Kooperationen mit Kinderschutzorganisationen sowie regelmäßige Transparenzberichte sollen die Genauigkeit der KI weiter verbessern, auch wenn Experten vor möglichen Systemmängeln warnen.

Meta hat eine neue Reihe von KI-gestützten Schutzmaßnahmen eingeführt, die speziell darauf ausgelegt sind, die Sicherheit von Jugendlichen auf seinen Plattformen, einschließlich WhatsApp, Instagram und Facebook, zu erhöhen. Das Unternehmen gab bekannt, dass die fortschrittlichen KI-Chatbots schädliche Inhalte überwachen und filtern, verdächtige Interaktionen identifizieren und Benutzer oder Administratoren warnen, wenn potenziell gefährliches Verhalten erkannt wird. Diese Initiative steht im Einklang mit dem zunehmenden regulatorischen Druck und der öffentlichen Forderung nach stärkeren digitalen Schutzmaßnahmen für Minderjährige.

Die KI-Systeme werden natürliche Sprachverarbeitung (NLP) und Verhaltensanalysen nutzen, um Risiken wie Cybermobbing, Grooming und die Konfrontation mit unangemessenen Inhalten zu erkennen. Interne Untersuchungen von Meta zeigen, dass schädliche Interaktionen in sozialen Medien bei Nutzern im Alter von 13 bis 18 Jahren häufiger vorkommen als bisher angenommen, was die Notwendigkeit proaktiver Interventionen unterstreicht. Das Unternehmen betonte, dass diese Systeme private Unterhaltungen nicht in einer Weise überwachen werden, die die Privatsphäre der Nutzer verletzt, sondern sich stattdessen auf die Erkennung schädlicher Muster und Verhaltensweisen konzentrieren.

Eine der wichtigsten Funktionen der KI-Chatbots ist ihre Fähigkeit, potenziell gefährliche Unterhaltungen in Echtzeit zu erkennen und zu markieren. Das System kann beispielsweise Muster erkennen, die darauf hindeuten, dass ein Täter versucht, einen Minderjährigen zu manipulieren, und den Nutzer automatisch warnen oder in bestimmten Fällen die örtlichen Behörden benachrichtigen, wenn bestimmte Schwellenwerte erreicht werden. Meta hat außerdem Kontrollmechanismen für Nutzer implementiert, die es Jugendlichen ermöglichen, ihre Datenschutzeinstellungen individuell anzupassen und bestimmte Überwachungsfunktionen zu deaktivieren, um ein Gleichgewicht zwischen Sicherheit und Autonomie zu gewährleisten.

Die neuen Schutzmaßnahmen sind Teil von Metas umfassender Responsible AI-Initiative, die darauf abzielt, KI-Systeme zu entwickeln, die transparent, fair und wirksam bei der Minderung von Online-Risiken sind. Das Unternehmen arbeitet mit Kinderschutzorganisationen zusammen, um die KI-Modelle mit Datensätzen zu trainieren, die eine breite Palette schädlicher Online-Verhaltensweisen widerspiegeln. Diese Kooperationen sollen die Genauigkeit und kulturelle Relevanz der KI-Interventionen verbessern, insbesondere in verschiedenen Regionen und Sprachen.

Meta hat sich außerdem verpflichtet, regelmäßig Transparenzberichte zu veröffentlichen, in denen die Leistung der KI-Chatbots sowie die Anzahl der erkannten und bearbeiteten Vorfälle detailliert aufgeführt werden. Das Unternehmen räumt ein, dass KI-Systeme nicht unfehlbar sind und eine kontinuierliche Weiterentwicklung notwendig ist, um Fehlalarme zu reduzieren und sicherzustellen, dass das System die Nutzererfahrung nicht unverhältnismäßig beeinträchtigt. Laut interner Kennzahlen haben die Chatbots bereits in frühen Testphasen Tausende verdächtiger Interaktionen markiert, wobei ein wachsender Prozentsatz dieser Fälle als schädlich bestätigt wurde.

Branchenanalysten loben diesen Schritt als bedeutenden Fortschritt im digitalen Kinderschutz, warnen jedoch, dass KI allein nicht alle Online-Risiken lösen kann. Laut einem Experten wird der Erfolg der Initiative maßgeblich davon abhängen, wie effektiv die KI-Modelle trainiert werden und wie reaktionsschnell die Mechanismen sind, wenn ein Risiko erkannt wird. Während Meta die KI-Chatbots auf seinen Plattformen einführt, wird das Unternehmen weiterhin Feedback von Nutzern und Regulierungsbehörden sammeln, um das System zu verfeinern und aufkommende Bedenken anzugehen.

Quelle:

Haftungsausschluss: Der Inhalt dieses Artikels gibt ausschließlich die Meinung des Autors wieder und repräsentiert nicht die Plattform in irgendeiner Form. Dieser Artikel ist nicht dazu gedacht, als Referenz für Investitionsentscheidungen zu dienen.

Das könnte Ihnen auch gefallen

Top 3 Ausbruch-Coins für 2025: Ozak AI, Solana und Bitcoin führen die Prognose an

Können die von Qian Zhimin mitgenommenen 40 Milliarden Bitcoin nach China zurückgegeben werden?

Unsere Kernforderung ist sehr klar – die Rückgabe des Eigentums an die ursprünglichen Besitzer, also die Rückgabe an die chinesischen Geschädigten.

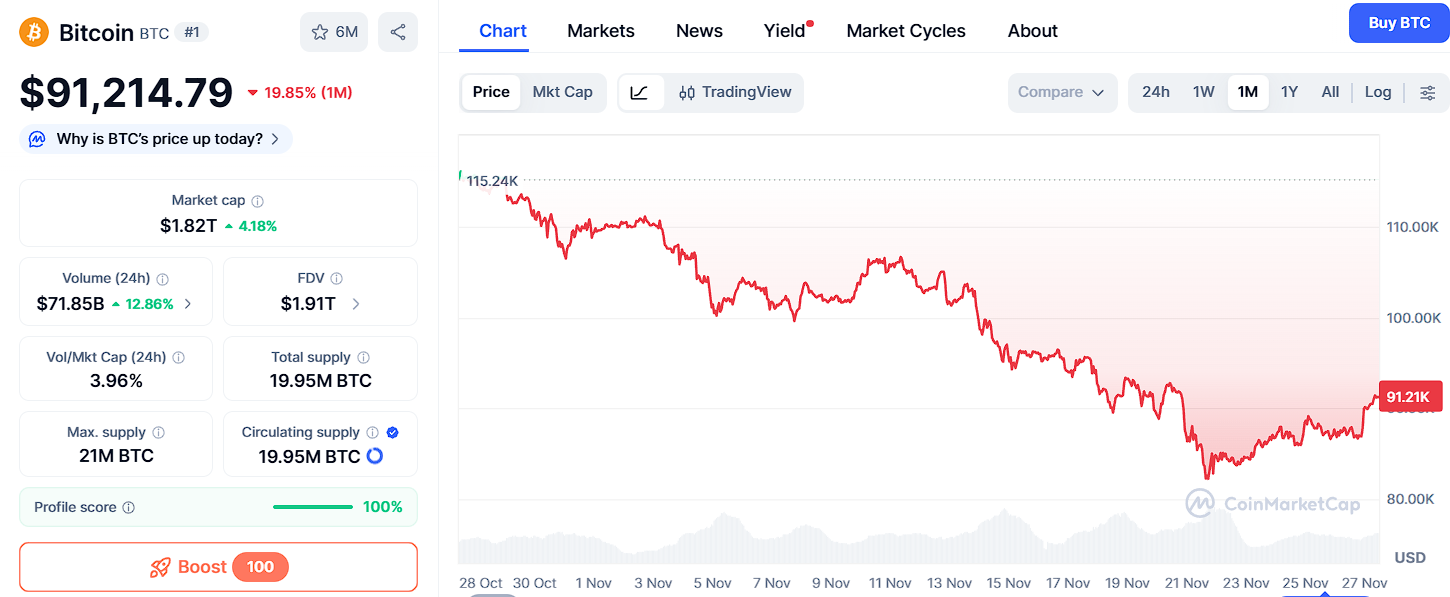

Bitcoin steigt, stolpert aber: Wird sich der Kryptomarkt erholen?

Kurz gefasst: Bitcoin konnte seine Position über 93.000 Dollar nicht halten und sieht sich starkem Verkaufsdruck ausgesetzt. Altcoins verzeichnen starke Rückgänge, wobei einige gemischte Entwicklungstrends aufweisen. Veränderungen bei den US-Spot-Bitcoin-ETF-Zuflüssen unterstreichen das vorsichtige Verhalten der Investoren.