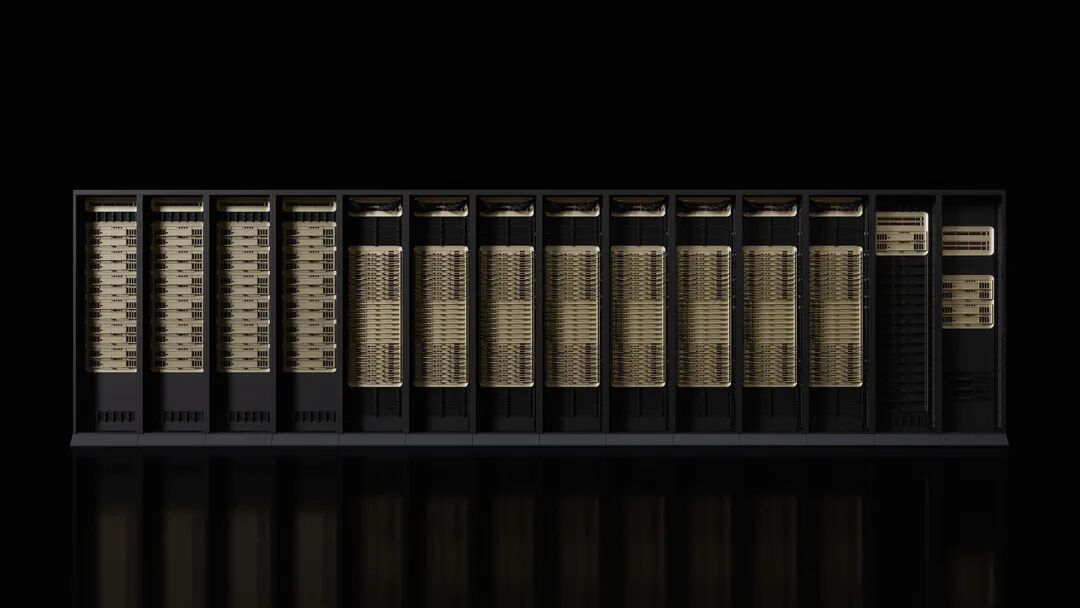

Nvidia lance la nouvelle génération de plateforme Rubin, avec un coût d'inférence dix fois inférieur à Blackwell, une livraison prévue pour le second semestre de l'année

Nvidia a présenté sa nouvelle génération de plateforme Rubin AI au salon CES, marquant ainsi la poursuite de son rythme de mise à jour annuelle dans le domaine des puces d'intelligence artificielle (IA). Grâce à une conception intégrée de six nouvelles puces, cette plateforme permet une amélioration significative des coûts d'inférence et de l'efficacité de l'entraînement, avec une première livraison prévue pour le second semestre 2026.

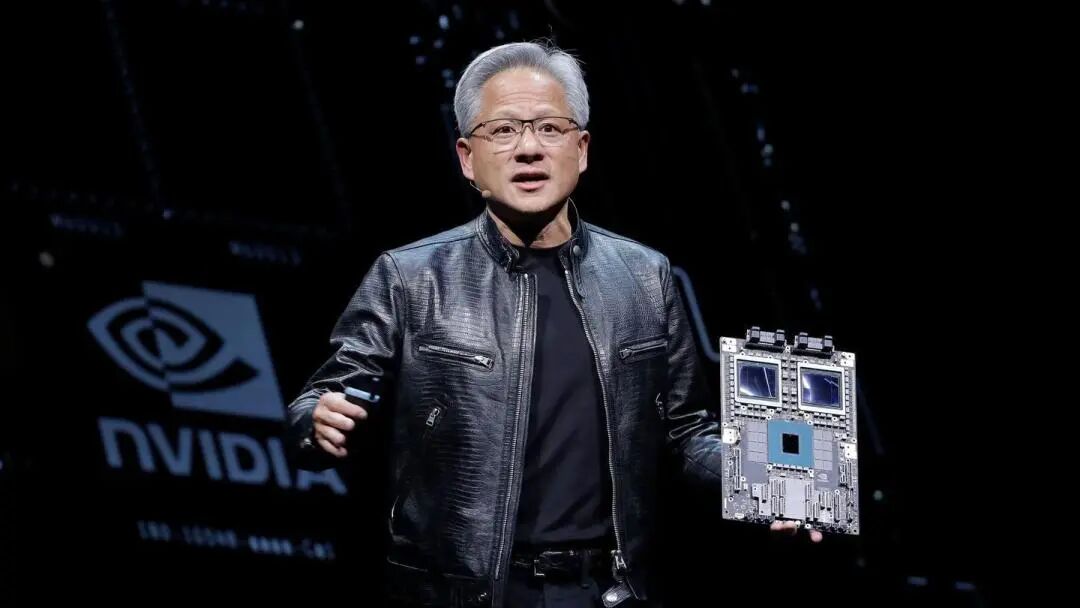

Le lundi 5, heure de la côte Est des États-Unis, le PDG de Nvidia, Jensen Huang, a déclaré à Las Vegas que les six puces Rubin étaient revenues de leurs partenaires fabricants et avaient passé certains tests clés, avançant selon le plan. Il a souligné que "la course à l'IA a commencé, tout le monde s'efforce d'atteindre le niveau suivant". Nvidia a précisé que les systèmes basés sur Rubin coûteraient moins à faire fonctionner que la version Blackwell, car ils permettent d'obtenir les mêmes résultats avec moins de composants.

Microsoft et d'autres grands fournisseurs de services cloud seront parmi les premiers clients à déployer le nouveau matériel au second semestre de l'année. La prochaine génération de super-usine d'IA Fairwater de Microsoft sera équipée du système en rack Nvidia Vera Rubin NVL72, évolutif à des centaines de milliers de superpuces Nvidia Vera Rubin. CoreWeave sera également l'un des premiers fournisseurs à proposer les systèmes Rubin.

Le lancement de cette plateforme intervient alors que certains acteurs de Wall Street s'inquiètent d'une concurrence accrue pour Nvidia et doutent que les dépenses dans le secteur de l'IA puissent maintenir leur rythme actuel. Nvidia maintient néanmoins des prévisions optimistes à long terme, estimant que la taille totale du marché pourrait atteindre plusieurs milliers de milliards de dollars.

Amélioration des performances pour répondre aux besoins de la nouvelle génération d'IA

Selon l'annonce de Nvidia, les performances d'entraînement de la plateforme Rubin sont 3,5 fois supérieures à celles de la génération précédente Blackwell, et les performances pour exécuter des logiciels d'IA sont multipliées par 5. Comparée à la plateforme Blackwell, Rubin peut réduire jusqu'à dix fois le coût de génération de tokens d'inférence, et le nombre de GPU nécessaires pour entraîner des modèles experts mixtes (MoE) est réduit par 4.

Le nouveau plateau est équipé du CPU Vera à 88 cœurs, dont la performance est le double des produits qu'il remplace. Ce CPU, spécifiquement conçu pour l'inférence proxy, est le processeur le plus efficace énergétiquement dans les usines d'IA à grande échelle. Il utilise 88 cœurs Olympus personnalisés, une compatibilité complète Armv9.2 et une connexion NVLink-C2C ultra-rapide.

Le GPU Rubin est doté d'un moteur Transformer de troisième génération, avec une accélération matérielle de la compression adaptative, offrant une puissance de calcul NVFP4 de 50 pétaflops pour l'inférence IA. Chaque GPU fournit une bande passante de 3,6 To/s, tandis que le rack Vera Rubin NVL72 offre une bande passante de 260 To/s.

Les tests des puces progressent sans accroc

Jensen Huang a révélé que les six puces Rubin sont revenues des partenaires fabricants et ont passé des tests clés démontrant leur capacité à être déployées comme prévu. Cette déclaration montre que Nvidia maintient sa position de leader parmi les fabricants d'accélérateurs IA.

La plateforme inclut cinq technologies innovantes : la sixième génération de technologie d'interconnexion NVLink, le moteur Transformer, l'informatique confidentielle, le moteur RAS, et le CPU Vera. Parmi celles-ci, la troisième génération d'informatique confidentielle fait du Vera Rubin NVL72 la première plateforme en rack offrant une protection des données sécurisée à travers les domaines CPU, GPU et NVLink.

Le moteur RAS de seconde génération s'étend au GPU, au CPU et à NVLink, offrant des fonctions de vérification de l'état en temps réel, de tolérance aux pannes et de maintenance proactive afin de maximiser la productivité du système. Le rack adopte une conception modulaire sans plateau de câbles, rendant l'assemblage et la maintenance 18 fois plus rapides que sur Blackwell.

Soutien d'un écosystème étendu

Nvidia précise qu'AWS d'Amazon, Google Cloud, Microsoft et Oracle Cloud seront les premiers à déployer des instances basées sur Vera Rubin en 2026. Les partenaires cloud CoreWeave, Lambda, Nebius et Nscale suivront également.

Sam Altman, CEO d'OpenAI, déclare : « L'intelligence s'accroît à mesure que les capacités de calcul grandissent. Au fur et à mesure que nous ajoutons de la puissance de calcul, les modèles deviennent plus puissants, capables de résoudre des problèmes plus complexes et d'avoir un plus grand impact pour les gens. La plateforme Rubin de Nvidia nous aide à poursuivre cette expansion.»

Dario Amodei, cofondateur et CEO d'Anthropic, estime que « l'amélioration de l'efficacité de la plateforme Rubin de Nvidia représente une avancée d'infrastructure permettant une mémoire plus longue, un meilleur raisonnement et des sorties plus fiables ».

Mark Zuckerberg, CEO de Meta, déclare que « la plateforme Rubin de Nvidia promet un bond en performance et en efficacité, ce qui est nécessaire pour déployer les modèles de pointe auprès de milliards de personnes ».

Nvidia ajoute que Cisco, Dell, Hewlett Packard Enterprise, Lenovo et Supermicro prévoient de lancer diverses gammes de serveurs basées sur les produits Rubin. Des laboratoires d'IA tels qu'Anthropic, Cohere, Meta, Mistral AI, OpenAI et xAI attendent avec impatience d'utiliser la plateforme Rubin pour entraîner des modèles encore plus grands et plus puissants.

Détail des produits dévoilés en avance

Selon certains commentaires, Nvidia a révélé les détails de ses nouveaux produits plus tôt que les années précédentes, dans le but de maintenir la dépendance de l'industrie à son matériel. Habituellement, Nvidia présente en détail ses produits lors de l'événement GTC organisé chaque printemps à San Jose, Californie.

Pour Jensen Huang, le CES n'est qu'une étape de plus dans son marathon d'annonces lors de divers événements. Il doit annoncer des produits, collaborations et investissements, tous visant à dynamiser le déploiement des systèmes d'IA.

Les nouveaux matériels annoncés par Nvidia incluent également des composants réseau et de connexion, qui feront partie du superordinateur DGX SuperPod, mais pourront aussi être utilisés comme produits indépendants de manière plus modulaire. Cette amélioration des performances est nécessaire, car l'IA s'oriente désormais vers des réseaux de modèles plus spécialisés, qui doivent non seulement filtrer d'énormes volumes de données, mais aussi résoudre des problèmes spécifiques à travers des processus en plusieurs étapes.

Nvidia fait avancer les applications de l'IA dans tous les secteurs de l'économie, y compris la robotique, la santé et l'industrie lourde. Dans ce cadre, Nvidia a lancé une série d'outils destinés à accélérer le développement des véhicules autonomes et des robots. Actuellement, la majorité des dépenses informatiques sur Nvidia provient du budget d'investissement de quelques clients clés, notamment Microsoft, Google Cloud (filiale d'Alphabet) et AWS (filiale d'Amazon).

Avertissement : le contenu de cet article reflète uniquement le point de vue de l'auteur et ne représente en aucun cas la plateforme. Cet article n'est pas destiné à servir de référence pour prendre des décisions d'investissement.

Vous pourriez également aimer

Tout le monde aura son propre ami IA dans cinq ans, selon un cadre de Microsoft

Le parcours du Bitcoin ce week-end déclenche de nouvelles tendances sur le marché