La prévision de 500 milliards de revenus est trop prudente ! La CFO de Nvidia affirme que « ce sera certainement plus élevé », Jensen Huang déclare que la demande des clients chinois est forte

Les cadres de Nvidia ne cessent d’envoyer des signaux optimistes, pariant sur les perspectives de ventes de Blackwell et de la prochaine génération de puces Rubin.

Le mardi 6, heure de la côte Est des États-Unis, la directrice financière de Nvidia, Colette Kress, a déclaré lors d’un événement organisé par JPMorgan que, en raison de la forte demande, Nvidia est désormais plus optimiste concernant son activité de centres de données, et que, d’ici fin 2026, les revenus attendus des puces pour centres de données de Nvidia "dépasseront certainement" la prévision de 500 milliards de dollars donnée en octobre dernier.

Les 500 milliards de dollars évoqués par Kress font référence à l’annonce faite par Jensen Huang lors de la GTC il y a un peu plus de deux mois, selon laquelle les puces de centres de données existantes et futures de Nvidia généreront environ 500 milliards de dollars de revenus d’ici la fin 2026. Goldman Sachs avait souligné fin octobre que cette prévision dépassait le consensus du marché d’environ 12 % à l’époque.

La déclaration de Kress prolonge l’optimisme exprimé cette semaine par le PDG de Nvidia, Jensen Huang, lors du Consumer Electronics Show (CES). Nvidia a officiellement lancé la puce Rubin lundi. Lors du discours principal de Huang au CES, il a révélé que la nouvelle plateforme Vera Rubin est désormais en pleine production, le coût d'inférence chutant à un dixième de celui de la plateforme Blackwell.

Huang a également souligné dans une interview avec les médias mardi que les nouvelles puces de Nvidia sont dix fois plus performantes que la génération précédente, et a indiqué que la demande des clients chinois est forte.

Malgré l’optimisme affiché par Kress et Huang, le cours de l’action Nvidia n’a pas inversé sa tendance baissière. Après avoir grimpé de plus de 2 % en début de séance mardi, l’action Nvidia est repartie à la baisse pour clôturer en repli de près de 0,5 %, signant ainsi une deuxième journée consécutive de baisse. En 2025, Nvidia a progressé d’environ 39 %, restant un moteur majeur de la hausse du marché américain, mais cette progression est bien inférieure à la hausse cumulée de plus de 170 % de 2024, principalement en raison des craintes de bulle autour de l’IA et de la concurrence des TPU de Google.

Prévisions de revenus continuellement relevées

Dans son discours de mardi, Kress a clairement indiqué que, depuis la prévision de 500 milliards de dollars donnée en octobre 2025, l’intérêt des clients de Nvidia n’a cessé de croître. S’agissant des prévisions de revenus des puces de centres de données, elle a déclaré : "Le chiffre de 500 milliards de dollars (prévu) sera certainement plus élevé."

Kress a souligné que l’optimisme de Nvidia concernant les applications de l’IA ne provient pas seulement de la demande en IA elle-même ; les besoins des entreprises en traitement des données stimulent également la croissance de la demande pour la prochaine génération de calcul, ce qui contribuera à porter les investissements globaux à plusieurs milliers de milliards de dollars d’ici la fin des années 2030.

Cette déclaration fait écho à la prévision de Jensen Huang du 28 octobre 2025 lors de la GTC. À l’époque, Huang avait révélé que l’entreprise avait une "visibilité" pour atteindre un chiffre d’affaires cumulé de 500 milliards de dollars dans les centres de données entre 2025 et 2026, une prévision qui couvre les produits Blackwell et la prochaine génération Rubin. Selon l’analyse de Goldman Sachs, cet objectif dépasse de 12 % le consensus du marché (Visible Alpha Consensus Data) de 447 milliards de dollars et de 10 % la prévision propre de Goldman Sachs de 453 milliards de dollars.

Début décembre 2025, Kress avait indiqué que le montant de 500 milliards de dollars de commandes ne comprenait pas les travaux en cours de Nvidia sur le prochain accord avec OpenAI, et avait révélé que l’accord d’investissement de 100 milliards de dollars précédemment annoncé avec OpenAI n’était pas encore finalisé. Elle avait alors déclaré que l’entreprise "avait certainement l’opportunité de recevoir davantage de commandes en plus des 500 milliards de dollars annoncés".

Lors de l’événement de mardi, Kress a été interrogée sur le rôle potentiel du marché chinois dans les revenus de Nvidia. Kress a indiqué que le gouvernement américain s’efforçait d’approuver les demandes de licences, que Nvidia avait déjà reçu des commandes de clients, mais que les résultats concrets restaient incertains.

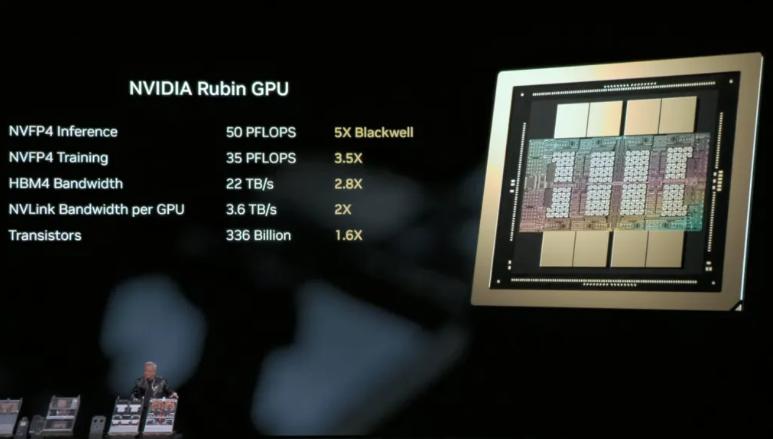

Production de masse complète de la plateforme Rubin

Lundi, au salon CES de Las Vegas, Jensen Huang a annoncé que la nouvelle plateforme d’IA Vera Rubin est désormais pleinement industrialisée. Il a indiqué que, grâce à une conception intégrée de six nouvelles puces, la plateforme a réalisé des sauts majeurs en termes de coût d’inférence et d’efficacité d’entraînement, avec une première livraison prévue pour la seconde moitié de 2026.

Huang a qualifié le GPU Rubin de "monstre géant", détaillant la logique de conception : "Le coût d’inférence de l’IA doit baisser d’un facteur 10 chaque année, tandis que le nombre de tokens générés par la 'pensée' de l’IA augmente d’un facteur 5 chaque année." Il a souligné que cette avancée, qui dépasse les attentes de la loi de Moore, découle d’une "conception synergique extrême" — une reconstruction totale du CPU, GPU, puce réseau et système de refroidissement.

Selon la présentation, le GPU Rubin atteint une performance d’inférence de 50 PFLOPS en précision NVFP4, soit 5 fois celle de Blackwell ; la performance d’entraînement atteint 35 PFLOPS, soit 3,5 fois celle de la génération précédente. Le coût de génération des tokens d’inférence peut être réduit jusqu’à un dixième de celui de la plateforme Blackwell. Chaque GPU embarque 8 modules de mémoire HBM4, atteignant une bande passante de 22 To/s. La prochaine génération de super-usines d’IA de Microsoft déploiera des centaines de milliers de puces Vera Rubin.

Pour résoudre le goulot d’étranglement de la "mémoire" en IA, Nvidia a construit une plateforme de stockage de mémoire contextuelle d’inférence basée sur le DPU BlueField-4, ajoutant à chaque GPU, en plus de la mémoire existante de 1 To, 16 To supplémentaires de mémoire partagée à haute vitesse, connectée via une bande passante de 200 Gb/s, ce qui résout le problème du "mur VRAM" pour les textes longs.

En matière d’efficacité énergétique, le rack Rubin NVL72 atteint un refroidissement 100 % liquide et supporte une température d’entrée d’eau de 45°C, ce qui signifie que les centres de données n’ont pas besoin de groupes frigorifiques à forte consommation d’énergie pour la dissipation thermique. Huang a déclaré que cela permettrait d’économiser 6 % de l’électricité des centres de données mondiaux.

Le discours de Jensen Huang entraîne une forte hausse des actions de stockage et une chute des actions de refroidissement de centres de données

Le discours de Jensen Huang au CES a eu un impact significatif sur les actions des secteurs concernés. Il a souligné que les systèmes d’IA nécessitent de la mémoire et du stockage, affirmant : "C’est un marché qui n’a jamais existé, il pourrait devenir le plus grand marché de stockage au monde, accueillant fondamentalement la mémoire de travail mondiale de l’IA".

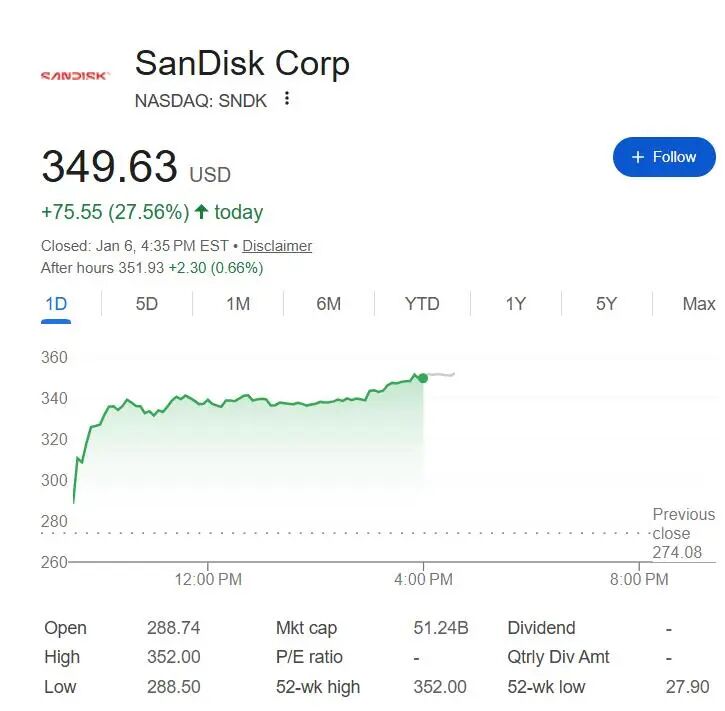

Portée par ce discours, SanDisk, géant des puces mémoire, est devenue la meilleure performance du S&P 500 mardi, son cours ayant clôturé en hausse de près de 27,6 %, la plus forte hausse journalière depuis le 18 février 2025.

SanDisk a progressé de plus de 40 % lors des trois premières séances de l’année et a grimpé d’environ 1 050 % depuis son point bas d’avril dernier. Les fabricants d’équipements de stockage Western Digital et Seagate Technology ont également enregistré des hausses à deux chiffres mardi.

Les fabricants de systèmes de refroidissement pour centres de données ont en revanche subi une forte correction. L’action Johnson Controls a chuté jusqu’à 11 % mardi, clôturant en baisse de plus de 6,2 %. Modine Manufacturing a perdu jusqu’à 21 % en séance avant de réduire ses pertes à une baisse de près de 7,5 % en clôture, tandis que Trane Technologies et Carrier Global ont respectivement reculé de 2,5 % et 0,5 %.

La chute des cours de ces entreprises découle des propos de Jensen Huang sur la possibilité d’utiliser la puce Rubin avec un refroidissement à eau tiède ne nécessitant pas de groupe frigorifique. Au salon CES, Huang a indiqué que les racks de serveurs dotés de la nouvelle puce Rubin pourront être refroidis à une température ne nécessitant pas de machine à eau froide, avec des flux d’air similaires à ceux des racks équipés de puces Blackwell.

Les études sectorielles indiquent que les groupes frigorifiques sont l'équipement "principal" fourni par Trane et Johnson Controls aux centres de données.

Dans un rapport, l’analyste de Baird, Timothy Wojs, a écrit que les commentaires de Jensen Huang "ont soulevé certaines questions et inquiétudes concernant la place à moyen terme des équipements de réfrigération dans les centres de données, en particulier avec la popularité croissante des technologies de refroidissement liquide".

L’analyste de Barclays, Julian Mitchell, a souligné : "Compte tenu de la position dominante de Nvidia dans l’ensemble de l’écosystème IA, même si ses déclarations semblent exagérées à première vue, elles sont à prendre très au sérieux."

Avertissement : le contenu de cet article reflète uniquement le point de vue de l'auteur et ne représente en aucun cas la plateforme. Cet article n'est pas destiné à servir de référence pour prendre des décisions d'investissement.

Vous pourriez également aimer

Jupiter, la DEX Solana, dévoile JupUSD, rendant aux utilisateurs le rendement natif du trésor

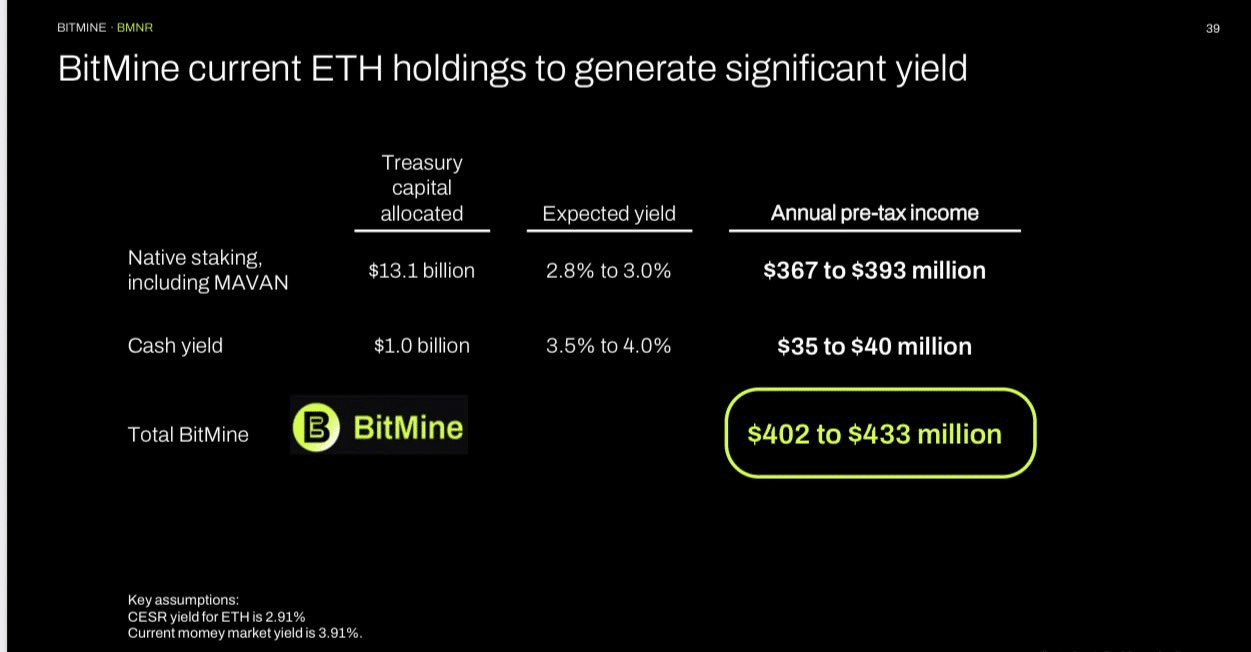

De 3 500 $ à 12 000 $ ? Voici pourquoi la prévision Ethereum de BMNR a du sens