Nvidia ra mắt nền tảng Rubin thế hệ mới, chi phí suy luận giảm 10 lần so với Blackwell, dự kiến giao hàng vào nửa cuối năm

Nvidia đã ra mắt nền tảng Rubin AI thế hệ mới tại triển lãm CES, đánh dấu nỗ lực duy trì nhịp độ cập nhật hàng năm trong lĩnh vực chip trí tuệ nhân tạo (AI). Nền tảng này tích hợp sáu chip mới, đạt bước nhảy vọt lớn về chi phí suy luận và hiệu suất huấn luyện, dự kiến giao hàng lô đầu tiên cho khách hàng vào nửa cuối năm 2026.

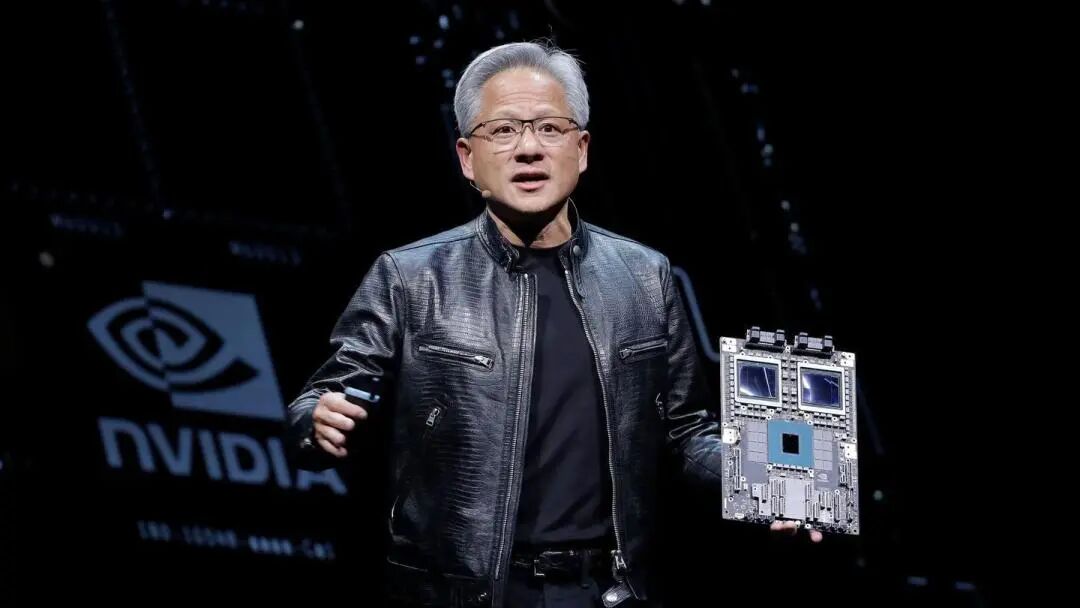

Vào ngày thứ Hai, ngày 5 theo giờ miền Đông nước Mỹ, CEO Nvidia Jensen Huang phát biểu tại Las Vegas rằng sáu chip Rubin đã được chuyển về từ các đối tác sản xuất và đã vượt qua một số kiểm tra quan trọng, đang tiến hành đúng kế hoạch. Ông nhấn mạnh "Cuộc đua AI đã bắt đầu, ai cũng nỗ lực vươn tới cấp độ tiếp theo". Nvidia nhấn mạnh rằng hệ thống dựa trên Rubin có chi phí vận hành thấp hơn phiên bản Blackwell, vì chúng đạt được kết quả tương tự với ít linh kiện hơn.

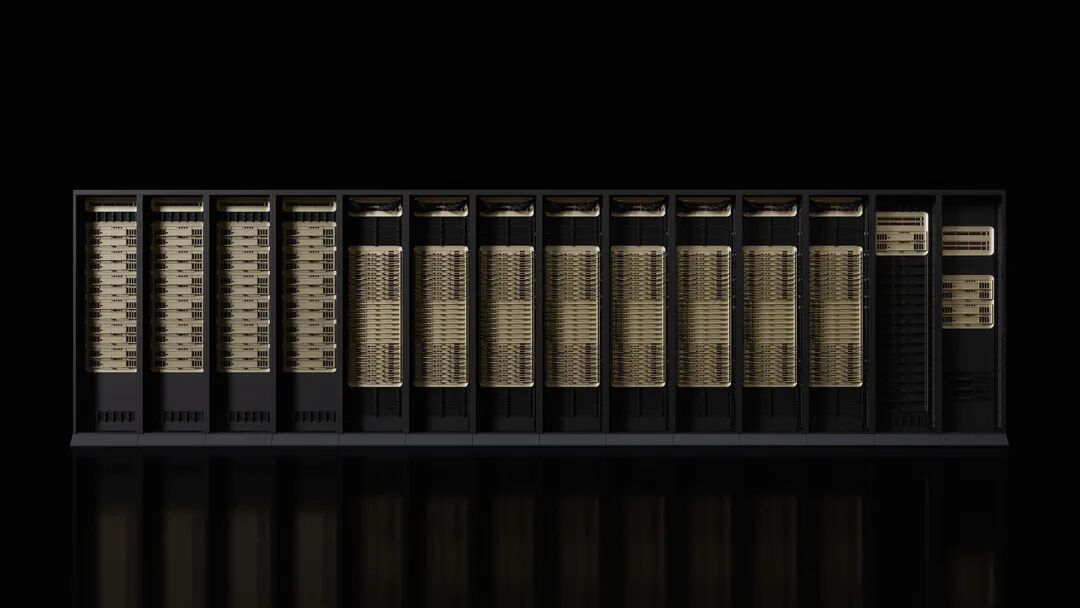

Microsoft và các nhà cung cấp dịch vụ điện toán đám mây lớn khác sẽ là những khách hàng đầu tiên triển khai phần cứng mới vào nửa cuối năm nay. Siêu nhà máy AI Fairwater thế hệ tiếp theo của Microsoft sẽ được trang bị hệ thống cấp rack Nvidia Vera Rubin NVL72, có thể mở rộng lên hàng trăm nghìn siêu chip Vera Rubin của Nvidia. CoreWeave cũng sẽ là một trong những nhà cung cấp đầu tiên cung cấp hệ thống Rubin.

Việc ra mắt nền tảng này diễn ra vào thời điểm một số nhà đầu tư Phố Wall lo lắng về sự cạnh tranh gia tăng mà Nvidia phải đối mặt, đồng thời nghi ngờ liệu chi tiêu cho AI có thể duy trì tốc độ hiện tại hay không. Tuy nhiên, Nvidia vẫn giữ dự báo lạc quan dài hạn, cho rằng quy mô thị trường tổng thể có thể lên tới hàng nghìn tỷ đô la Mỹ.

Tăng hiệu suất nhằm đáp ứng nhu cầu AI thế hệ mới

Theo công bố của Nvidia, hiệu suất huấn luyện của nền tảng Rubin cao gấp 3,5 lần so với Blackwell thế hệ trước, hiệu suất chạy phần mềm AI tăng 5 lần. So với nền tảng Blackwell, Rubin có thể giảm chi phí tạo token suy luận tới 10 lần, số lượng GPU cần thiết để huấn luyện mô hình chuyên gia hỗn hợp (MoE) giảm 4 lần.

Nền tảng mới được trang bị CPU Vera với 88 lõi, hiệu suất gấp đôi sản phẩm thay thế. CPU này được thiết kế dành riêng cho suy luận proxy, là bộ xử lý tiết kiệm năng lượng nhất trong các nhà máy AI quy mô lớn, sử dụng 88 lõi Olympus tùy biến, tương thích hoàn toàn với Armv9.2 và kết nối NVLink-C2C siêu nhanh.

GPU Rubin được trang bị động cơ Transformer thế hệ thứ ba, có tính năng nén tự thích ứng tăng tốc phần cứng, cung cấp khả năng tính toán NVFP4 50 petaflops cho suy luận AI. Mỗi GPU cung cấp băng thông 3,6TB/s, còn rack Vera Rubin NVL72 cung cấp băng thông 260TB/s.

Tiến độ kiểm tra chip thuận lợi

Jensen Huang tiết lộ, cả sáu chip Rubin đã trở về từ các đối tác sản xuất và đã vượt qua các bài kiểm tra quan trọng chứng minh có thể triển khai đúng kế hoạch. Phát biểu này cho thấy Nvidia tiếp tục duy trì vị thế là nhà sản xuất bộ tăng tốc AI hàng đầu.

Nền tảng này bao gồm năm công nghệ đột phá: công nghệ kết nối NVLink thế hệ thứ sáu, động cơ Transformer, điện toán bảo mật, động cơ RAS và CPU Vera. Trong đó, công nghệ điện toán bảo mật thế hệ ba biến Vera Rubin NVL72 thành nền tảng cấp rack đầu tiên cung cấp bảo vệ dữ liệu an toàn xuyên suốt CPU, GPU và miền NVLink.

Động cơ RAS thế hệ hai bao phủ GPU, CPU và NVLink, có chức năng kiểm tra sức khỏe theo thời gian thực, chịu lỗi và bảo trì chủ động để tối đa hóa năng suất hệ thống. Giá đỡ sử dụng thiết kế dạng mô-đun, không dây cáp, tốc độ lắp ráp và bảo trì nhanh hơn Blackwell 18 lần.

Hệ sinh thái rộng lớn hỗ trợ

Nvidia cho biết, bao gồm Amazon AWS, Google Cloud, Microsoft và Oracle Cloud sẽ tiên phong triển khai các instance dựa trên Vera Rubin vào năm 2026, các đối tác đám mây CoreWeave, Lambda, Nebius và Nscale cũng sẽ tiếp bước.

CEO OpenAI Sam Altman cho biết: “Trí tuệ mở rộng cùng với tính toán. Khi chúng ta thêm nhiều tính toán hơn, mô hình trở nên mạnh mẽ hơn, có thể giải quyết các vấn đề khó hơn, mang lại tác động lớn hơn cho con người. Nền tảng Rubin của Nvidia giúp chúng tôi tiếp tục mở rộng tiến trình này.”

Nhà đồng sáng lập kiêm CEO Anthropic Dario Amodei cho biết, “Hiệu quả tăng của nền tảng Rubin đại diện cho bước tiến hạ tầng cho phép thực hiện trí nhớ dài hơn, suy luận tốt hơn và đầu ra đáng tin cậy hơn.”

CEO Meta Mark Zuckerberg cho biết, “Nền tảng Rubin của Nvidia hứa hẹn mang lại bước thay đổi lớn về hiệu suất và hiệu quả, đây là điều cần thiết để triển khai các mô hình tiên tiến nhất đến hàng tỷ người.”

Nvidia cũng cho biết, Cisco, Dell, HPE, Lenovo và Supermicro dự kiến sẽ ra mắt các loại máy chủ dựa trên sản phẩm Rubin. Các phòng thí nghiệm AI như Anthropic, Cohere, Meta, Mistral AI, OpenAI và xAI đang mong đợi tận dụng nền tảng Rubin để huấn luyện các mô hình lớn hơn, mạnh mẽ hơn.

Công bố chi tiết sản phẩm sớm

Các nhận định cho rằng Nvidia năm nay công bố chi tiết sản phẩm mới sớm hơn thường lệ, đây là một trong những hành động giúp công ty duy trì sự phụ thuộc của ngành vào phần cứng của mình. Bởi Nvidia thường trình bày chi tiết sản phẩm tại sự kiện GTC tổ chức vào mùa xuân hàng năm ở San Jose, California.

Đối với Jensen Huang, CES chỉ là một điểm dừng nữa trong chuỗi sự kiện marathon mà ông tham dự. Ông phải công bố sản phẩm, hợp tác và đầu tư tại nhiều sự kiện khác nhau, tất cả đều nhằm thúc đẩy triển khai hệ thống AI.

Phần cứng mới mà Nvidia công bố cũng bao gồm các thành phần mạng và kết nối, sẽ là một phần của siêu máy tính DGX SuperPod, đồng thời cũng có thể được bán riêng lẻ để khách hàng sử dụng theo cách mô-đun hơn. Việc nâng cấp hiệu suất này là cần thiết, vì AI đã chuyển sang mạng mô hình chuyên biệt hơn, không chỉ lọc lượng lớn đầu vào mà còn phải giải quyết các vấn đề cụ thể qua nhiều giai đoạn.

Nvidia đang thúc đẩy ứng dụng AI trên toàn bộ lĩnh vực kinh tế, bao gồm robot, chăm sóc sức khỏe và công nghiệp nặng. Là một phần của nỗ lực này, Nvidia đã công bố một loạt công cụ nhằm tăng tốc phát triển xe tự lái và robot. Hiện tại, phần lớn chi tiêu cho máy tính dựa trên Nvidia đến từ ngân sách đầu tư của một số khách hàng lớn, bao gồm Microsoft, Google Cloud thuộc Alphabet và AWS thuộc Amazon.

Tuyên bố miễn trừ trách nhiệm: Mọi thông tin trong bài viết đều thể hiện quan điểm của tác giả và không liên quan đến nền tảng. Bài viết này không nhằm mục đích tham khảo để đưa ra quyết định đầu tư.

Bạn cũng có thể thích

Vị thế hợp đồng tương lai FX của USD/JPY, EUR/USD, USD/CHF | Phân tích COT

Đô la Úc giữ ổn định khi kinh tế Trung Quốc tăng trưởng trong quý IV năm 2025

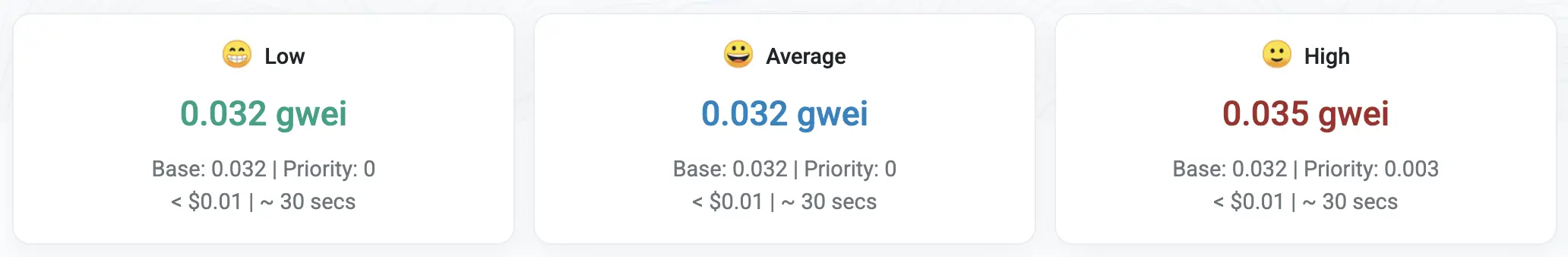

Cách Ethereum âm thầm giải quyết vấn đề phí gas 50 đô la vào năm 2026