Deepseek v3.2... Neue Open-Source-SOTA (1. Dezember)

Ein optimierter Informationsfluss

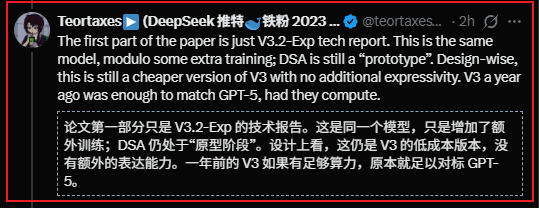

Ein optimierter Informationsfluss Ich habe gerade in der U-Bahn die Veröffentlichung von deepseek studiert...

Hier eine schnelle Zusammenfassung:

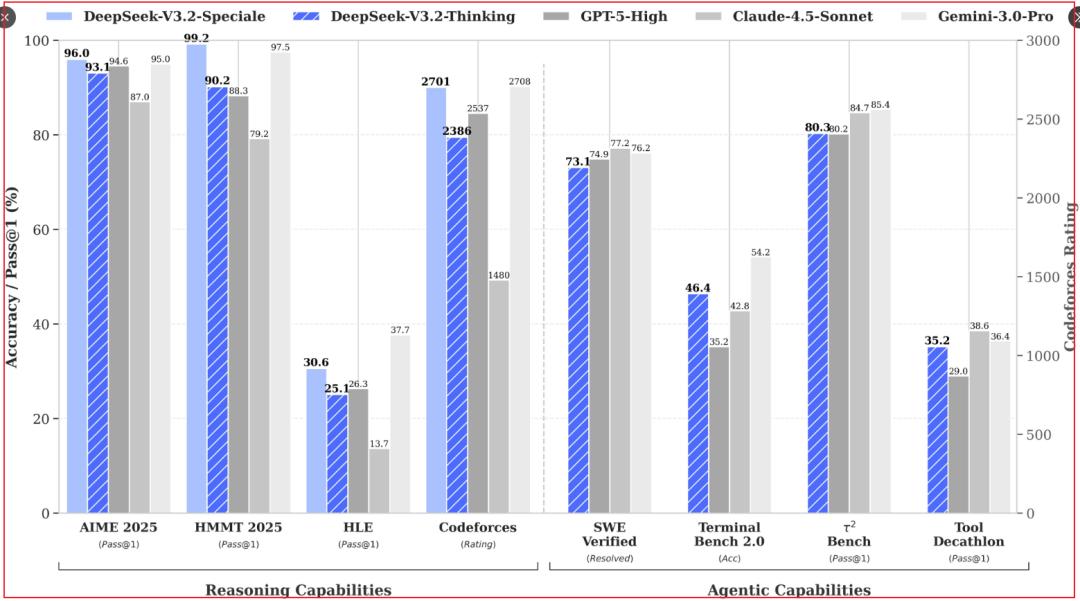

1/ Das Ergebnis, das deepseek diesmal geliefert hat, ist wirklich beeindruckend gut.

- Ohne Zweifel ein Open-Source-SOTA;

- Die Fähigkeiten orientieren sich im Grunde an den führenden, geschlossenen Modellen;

2/ Technisch ist das Ganze nicht besonders neu,

- DSA + Post-Training mit über 10% Anteil ist keine große Neuigkeit;

- Die neue Information ist, dass mit den Elementen aus der letzten v3.2-Experimentversion solch gute Ergebnisse erzielt wurden und direkt mit gemini3.0, einem der neuesten SOTA-Modelle, konkurriert werden kann;

- In der wissenschaftlichen Literatur lässt sich der Marktdiskurs heute kaum noch anstoßen; die gezeigten Fähigkeiten sind diesmal deutlich anschaulicher.

3/ Der befürchtete Einbruch bei der Rechenleistung? Gibt es nicht.

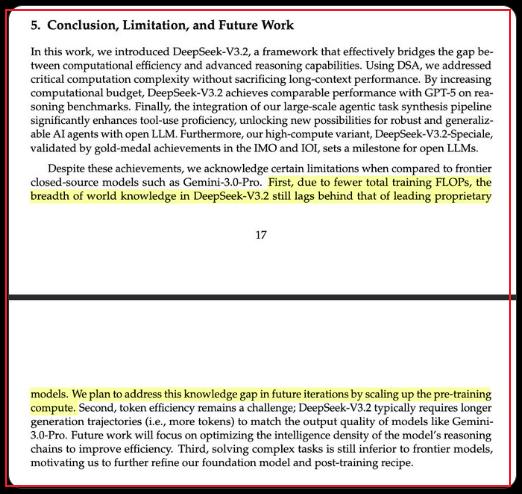

Laut deepseek selbst haben wir immer noch einen Abstand zu den führenden Modellen.

Aus einer anderen Perspektive betrachtet: Der "Wissensgraben" auf Modellebene ist nicht existent,die Rechenleistung bleibt ein differenzierender Faktor.

Die Meinung von Deepseek-Forscher Zhibin Gou: gemini3 beweist Pretrain...deepseek 3.2 beweist RL;

Weiterhin Scaling auf allen Ebenen betreiben; nicht vom Lärm des "gegen die Wand Laufens" ablenken lassen.

Mehr RL, längere CoT, höherer Rechenaufwand beim Inferencing;aus diesen Gründen wird keine Deflation bei der Rechenleistung entstehen.

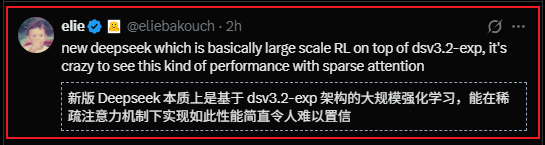

4/ Aus Anwendungssicht... auf jeden Fall positiv. Zitieren wir einen Kommentar aus der Community:

-

„Der Bedarf an Rechenleistung ist endlos, der praktische Wert der aktuellen Token-Kosten ist sehr gering. Erst durch Innovationen bei Hardware und Modellen und damit einer exponentiellen Kostensenkung ist eine breite Anwendung möglich.“

-

Für Unternehmen, die versuchen, über die „Modellfähigkeit“ eine Burg für ihre Anwendungen zu bauen (zum Beispiel ein gewisses OAI),ist dies eine deutliche Schwächung der Storyline.

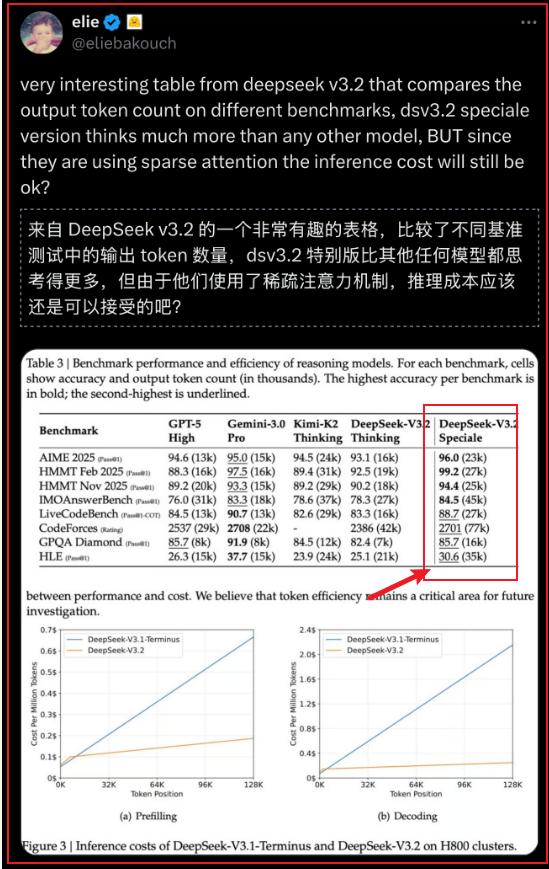

5/ Deepseek gibt selbst an, dass die Effizienz bei der Tokennutzung „unterlegen“ ist... In der Speciale-Version werden tatsächlich mehr Tokens verwendet...(siehe roter Rahmen)..

6/ Easter-Egg: Zhibin Gou sagte, sie hätten ein Jahr gebraucht, um v3 an seine Grenzen zu bringen... Einige Gruppenmitglieder meinen, v3 sei nun ausgequetscht,kommt nun endlich v4?

7/ Heute ist anscheinend der 3. Jahrestag der Veröffentlichung von ChatGPT...

Heute Abend dürfte der Markt recht volatil sein... einige chaotische makroökonomische Faktoren aus Japan + BTC sorgen für Unruhe;

Das nächste kleinere Katalysator-Ereignis könnte Amazons re:invent sein; heute Morgen gab es dazu im Gruppenchat bereits einen kleinen Ausblick.

Haftungsausschluss: Der Inhalt dieses Artikels gibt ausschließlich die Meinung des Autors wieder und repräsentiert nicht die Plattform in irgendeiner Form. Dieser Artikel ist nicht dazu gedacht, als Referenz für Investitionsentscheidungen zu dienen.

Das könnte Ihnen auch gefallen

Anthropics Claude Code ist das KI-Tool, über das momentan jeder spricht

Carneys engere Beziehungen zu China vertiefen die Kluft zu den USA angesichts von Trumps Zollpolitik

Fed-Protokolle zeigen, dass Vorsitzender Powell 2020 auf eine entschlossene Anleitung zu den Zinssätzen drängte

Gerovich von Metaplanet und Lee von Bitmine trommeln für unternehmerische Krypto-Bestände