Kurz gefasst

- DeepSeek V4 könnte innerhalb weniger Wochen erscheinen und zielt auf eine Elite-Performance im Coding-Bereich ab.

- Insider behaupten, es könnte Claude und ChatGPT bei Aufgaben mit besonders langen Code-Kontexten schlagen.

- Entwickler sind bereits im Vorfeld einer möglichen Disruption in Aufregung.

DeepSeek plant Berichten zufolge, sein V4-Modell um Mitte Februar herauszubringen. Sollten interne Tests zutreffen, sollten die KI-Giganten des Silicon Valley nervös werden.

Das in Hangzhou ansässige KI-Startup könnte laut eine Veröffentlichung rund um den 17. Februar – natürlich zum Mondneujahr – anstreben, mit einem speziell auf Coding-Aufgaben zugeschnittenen Modell.

. Personen mit direkter Kenntnis des Projekts behaupten, dass V4 sowohl Anthropics Claude als auch OpenAIs GPT-Reihe in internen Benchmarks übertrifft, insbesondere bei der Verarbeitung extrem langer Code-Prompts.

Natürlich wurden keine Benchmarks oder Informationen über das Modell öffentlich geteilt, sodass sich solche Behauptungen nicht direkt überprüfen lassen. DeepSeek hat die Gerüchte ebenfalls nicht bestätigt.

Dennoch wartet die Entwickler-Community nicht auf eine offizielle Bestätigung. Reddits r/DeepSeek und r/LocalLLaMA laufen bereits heiß, Nutzer horten API-Credits und Enthusiasten auf X teilen eifrig ihre Prognosen, dass V4 DeepSeeks Position als Underdog festigen könnte, der sich nicht an die milliardenschweren Regeln des Silicon Valley hält.

Anthropic hat Claude-Abos in Drittanbieter-Apps wie OpenCode blockiert und offenbar auch den Zugang von xAI und OpenAI gekappt.

Claude und Claude Code sind großartig, aber noch nicht 10x besser. Das wird andere Labs nur dazu bringen, schneller an ihren Coding-Modellen/Agents zu arbeiten.

DeepSeek V4 soll angeblich bald erscheinen…

— Yuchen Jin (@Yuchenj_UW) 9. Januar 2026

Dies wäre nicht die erste Disruption von DeepSeek. Als das Unternehmen im Januar 2025 sein R1-Reasoning-Modell veröffentlichte, löste es einen Ausverkauf von einer Billion Dollar an den Weltmärkten aus.

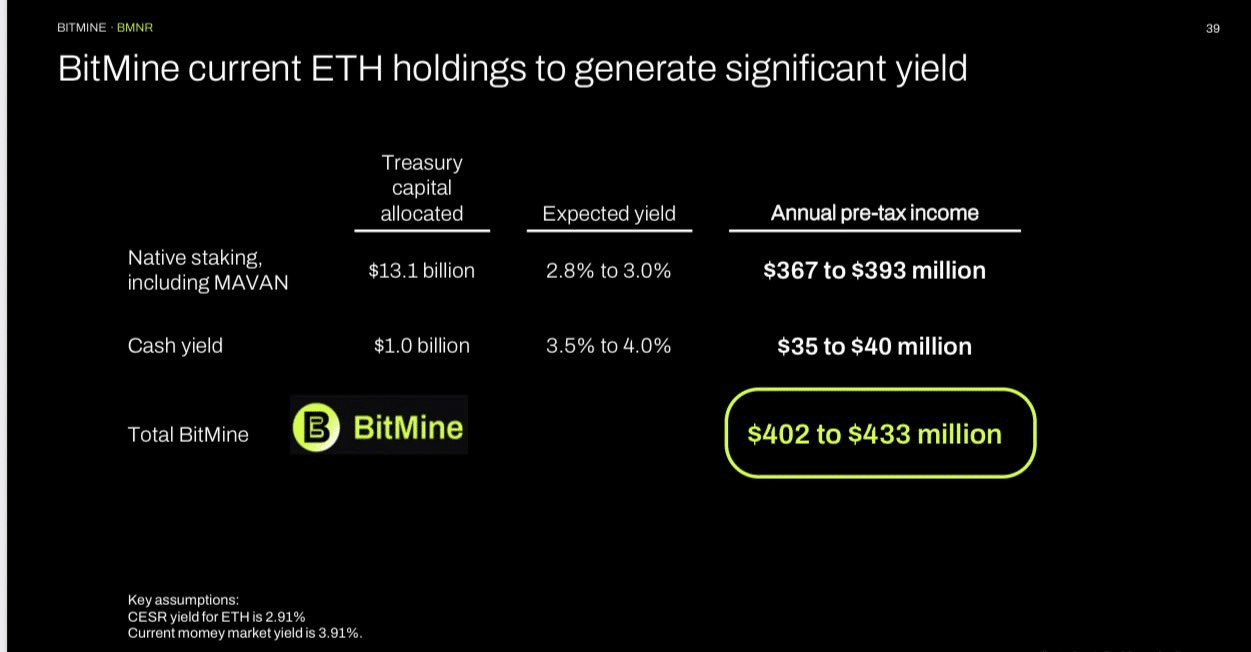

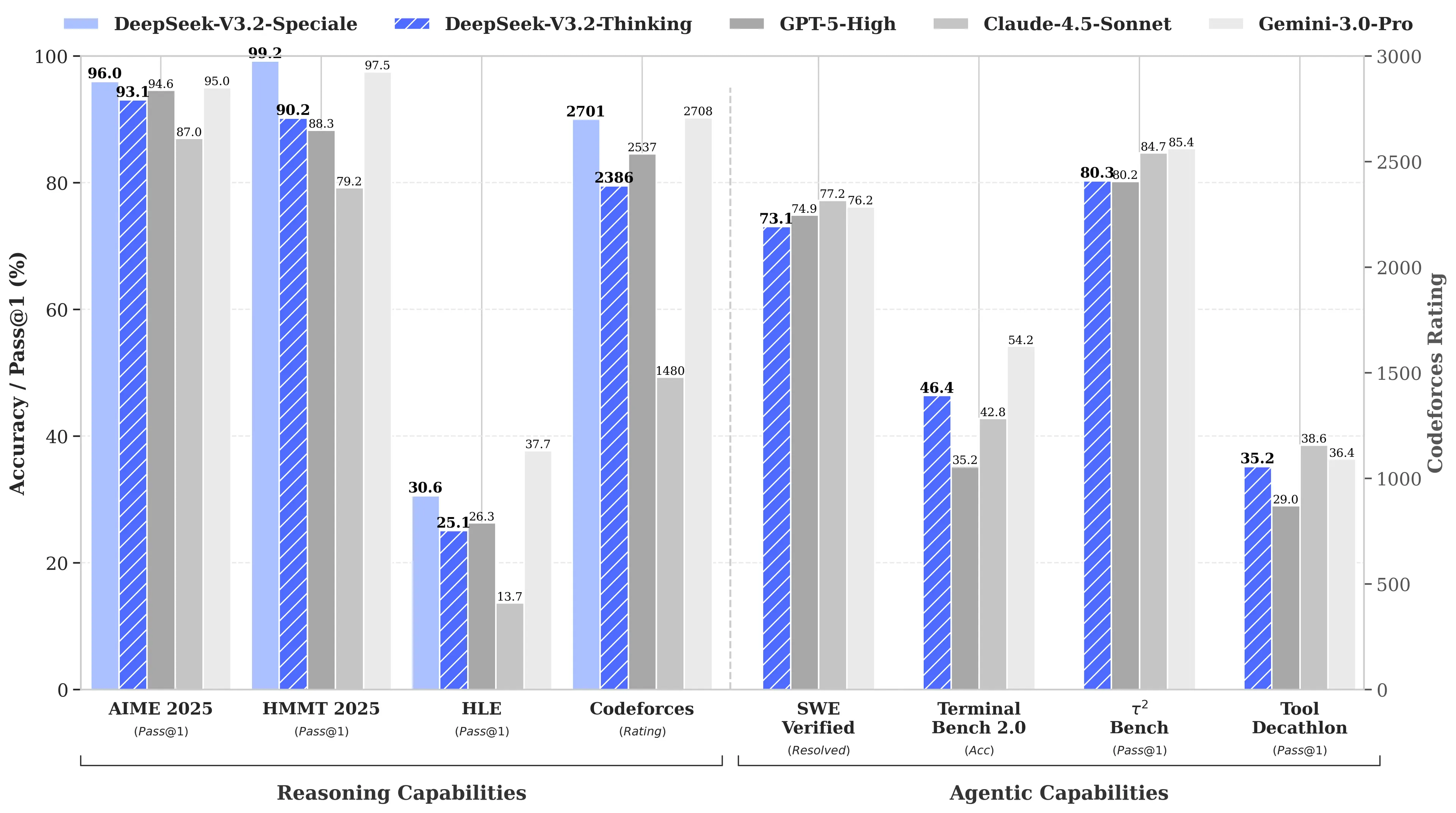

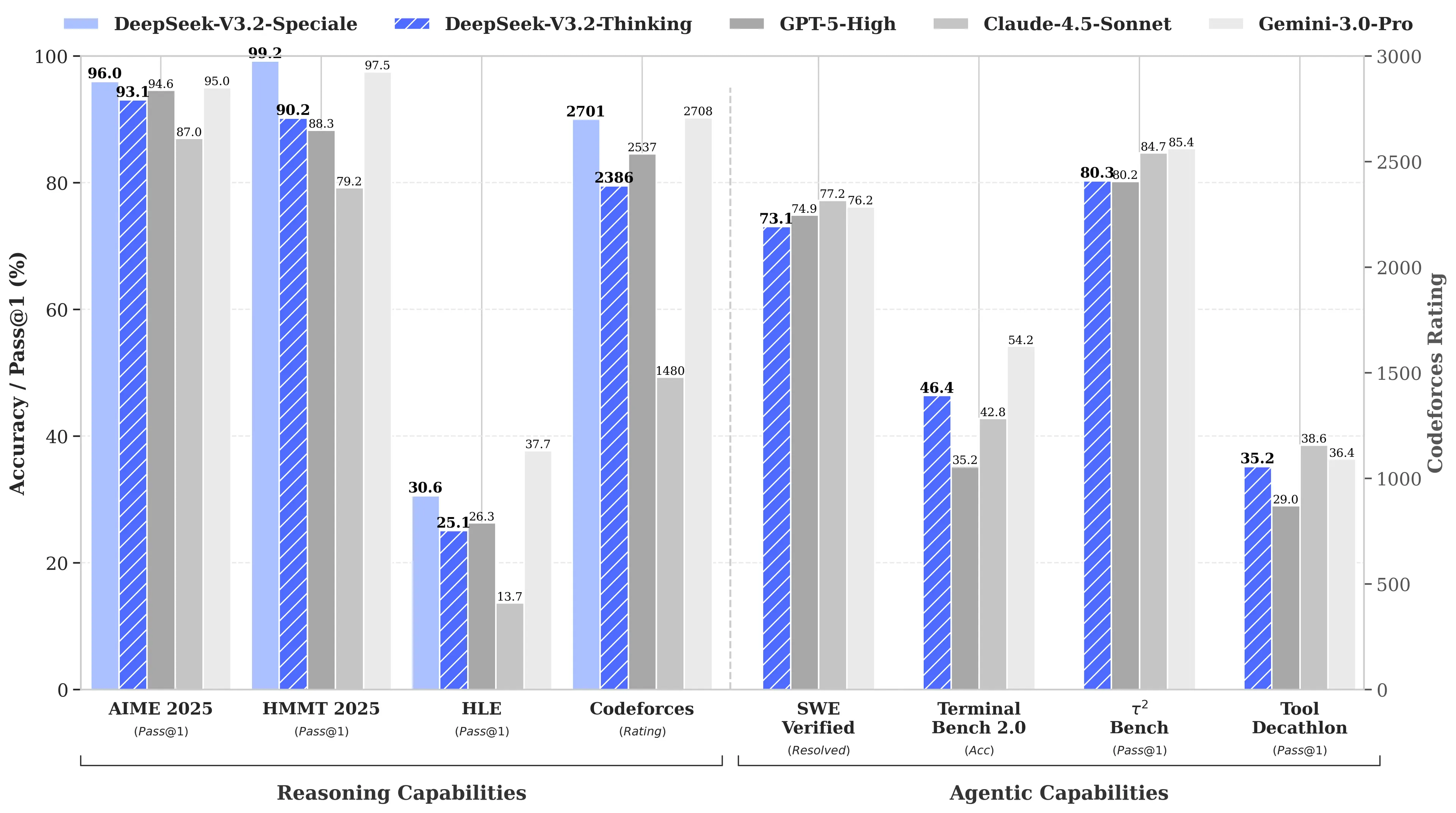

Der Grund? DeepSeeks R1 erreichte bei Mathematik- und Reasoning-Benchmarks das Niveau von OpenAIs o1-Modell, obwohl die Entwicklung Berichten zufolge nur 6 Millionen Dollar kostete – etwa 68-mal günstiger, als Mitbewerber ausgaben. Das V3-Modell erreichte später 90,2% beim MATH-500-Benchmark und übertraf damit Claudes 78,3%. Das jüngste Update „V3.2 Speciale“ verbesserte die Leistung nochmals deutlich.

Bild: DeepSeek

V4s Fokus auf Coding wäre eine strategische Neuausrichtung. Während R1 auf reines Reasoning – Logik, Mathematik, formale Beweise – setzte, ist V4 ein hybrides Modell (Reasoning und Non-Reasoning-Aufgaben), das den Markt für Enterprise-Entwickler adressiert, wo hochpräzise Codegenerierung direkt in Umsätze übersetzt wird.

Um die Vorherrschaft zu beanspruchen, müsste V4 Claude Opus 4.5 schlagen, das aktuell mit 80,9% den Rekord bei SWE-bench Verified hält. Aber wenn frühere DeepSeek-Releases ein Hinweis sind, könnte dies selbst unter allen Einschränkungen, denen ein chinesisches KI-Labor ausgesetzt ist, nicht unmöglich sein.

Die nicht ganz geheime Zutat

Angenommen, die Gerüchte stimmen – wie kann dieses kleine Labor einen solchen Erfolg erzielen?

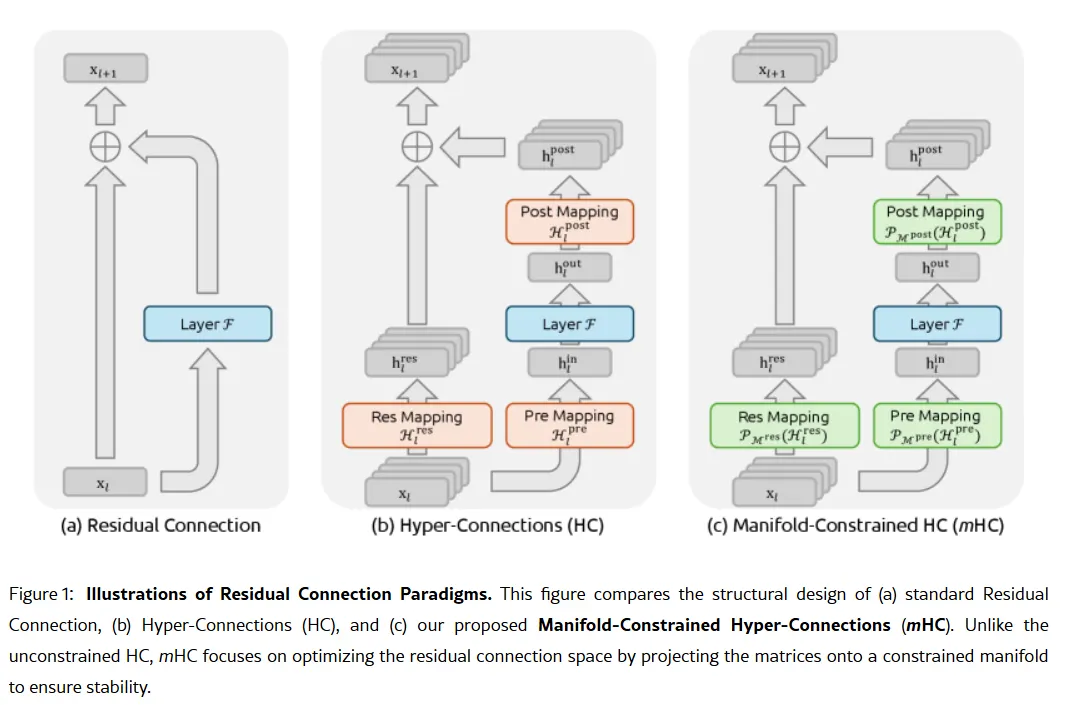

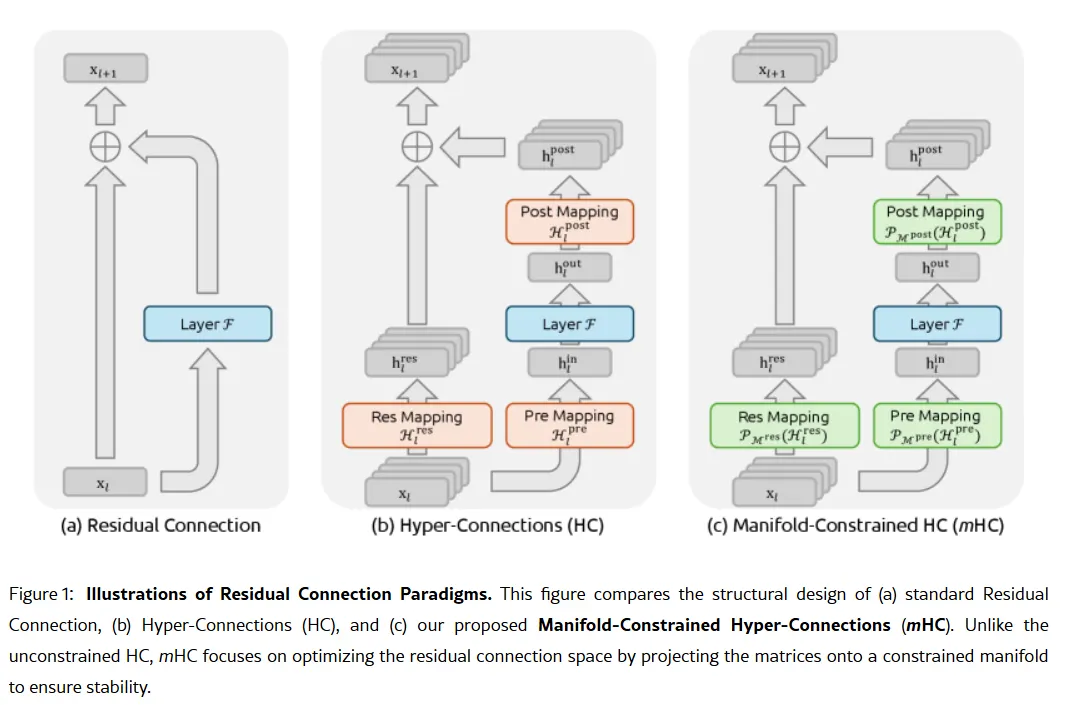

Die Geheimwaffe des Unternehmens könnte in einem Forschungspapier vom 1. Januar beschrieben sein: Manifold-Constrained Hyper-Connections, oder mHC. Das von Gründer Liang Wenfeng mitverfasste neue Trainingsverfahren adressiert ein fundamentales Problem beim Skalieren großer Sprachmodelle – wie sich die Modellkapazität erhöhen lässt, ohne dass das Training instabil wird oder „explodiert“.

Traditionelle KI-Architekturen führen alle Informationen durch einen einzigen, engen Pfad. mHC erweitert diesen Pfad in mehrere Ströme, die Informationen austauschen können, ohne dass das Training zusammenbricht.

Bild: DeepSeek

Wei Sun, leitende Analystin für KI bei Counterpoint Research, bezeichnete mHC in Kommentaren gegenüber als „bemerkenswerten Durchbruch“.

. Die Technik zeige, so Sun, dass DeepSeek „Rechen-Engpässe umgehen und Sprünge in der Intelligenz ermöglichen“ könne – selbst bei begrenztem Zugang zu fortgeschrittenen Chips aufgrund der US-Exportbeschränkungen.

Lian Jye Su, Chefanalyst bei Omdia, merkte an, dass DeepSeeks Bereitschaft, seine Methoden zu veröffentlichen, auf ein „neues Selbstbewusstsein der chinesischen KI-Industrie“ hindeute. Der Open-Source-Ansatz des Unternehmens hat es bei Entwicklern beliebt gemacht, die es als Verkörperung dessen sehen, was OpenAI einst war, bevor das Unternehmen auf geschlossene Modelle und milliardenschwere Fundraising-Runden umschwenkte.

Nicht alle sind überzeugt. Einige Entwickler auf Reddit beklagen, dass DeepSeeks Reasoning-Modelle Rechenleistung an triviale Aufgaben verschwenden, während Kritiker anmerken, dass die Benchmarks des Unternehmens die Unordnung der realen Welt nicht widerspiegeln. Ein Medium-Post mit dem Titel „DeepSeek Sucks—And I'm Done Pretending It Doesn't“ ging im April 2025 viral und warf den Modellen vor, „Standard-Nonsens mit Bugs“ und „halluzinierte Bibliotheken“ zu produzieren.

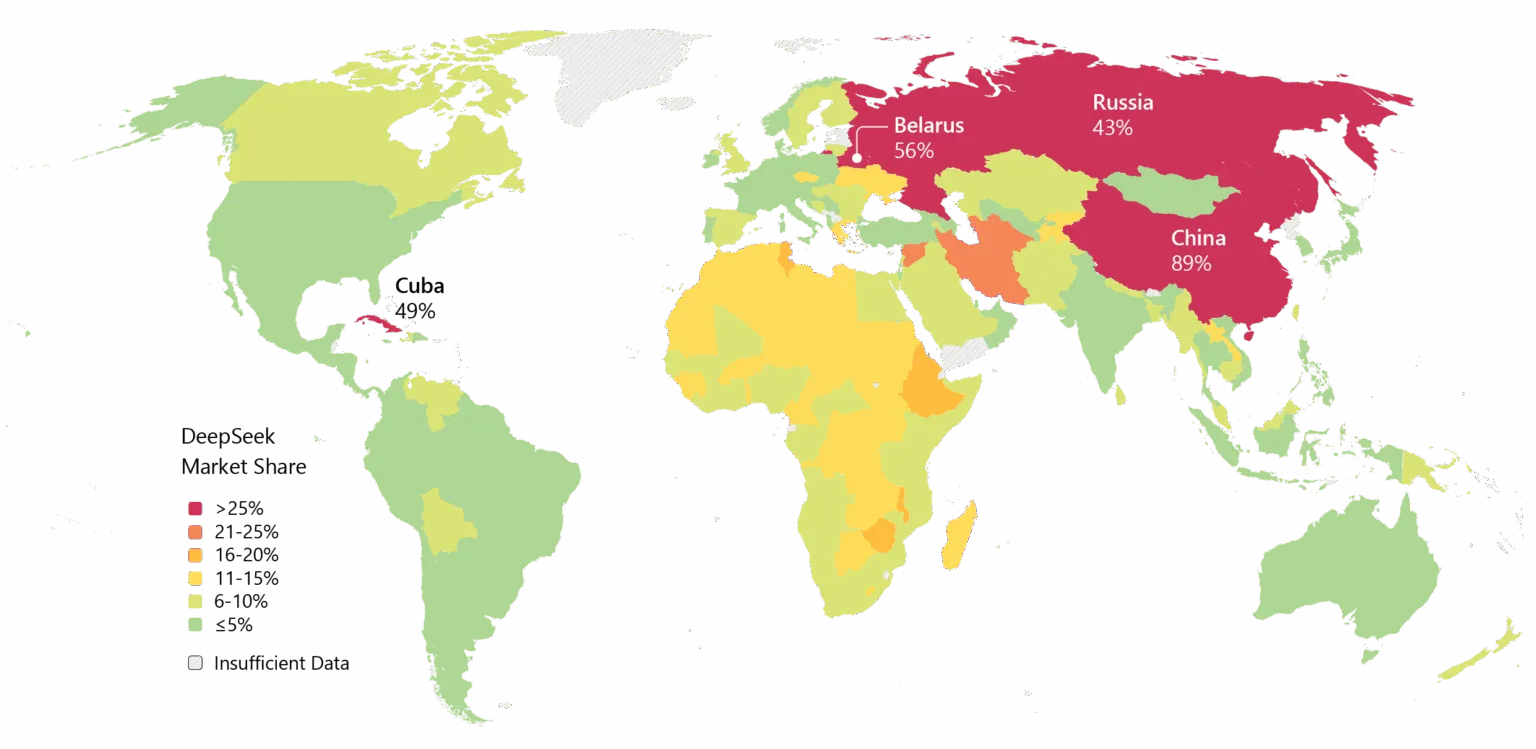

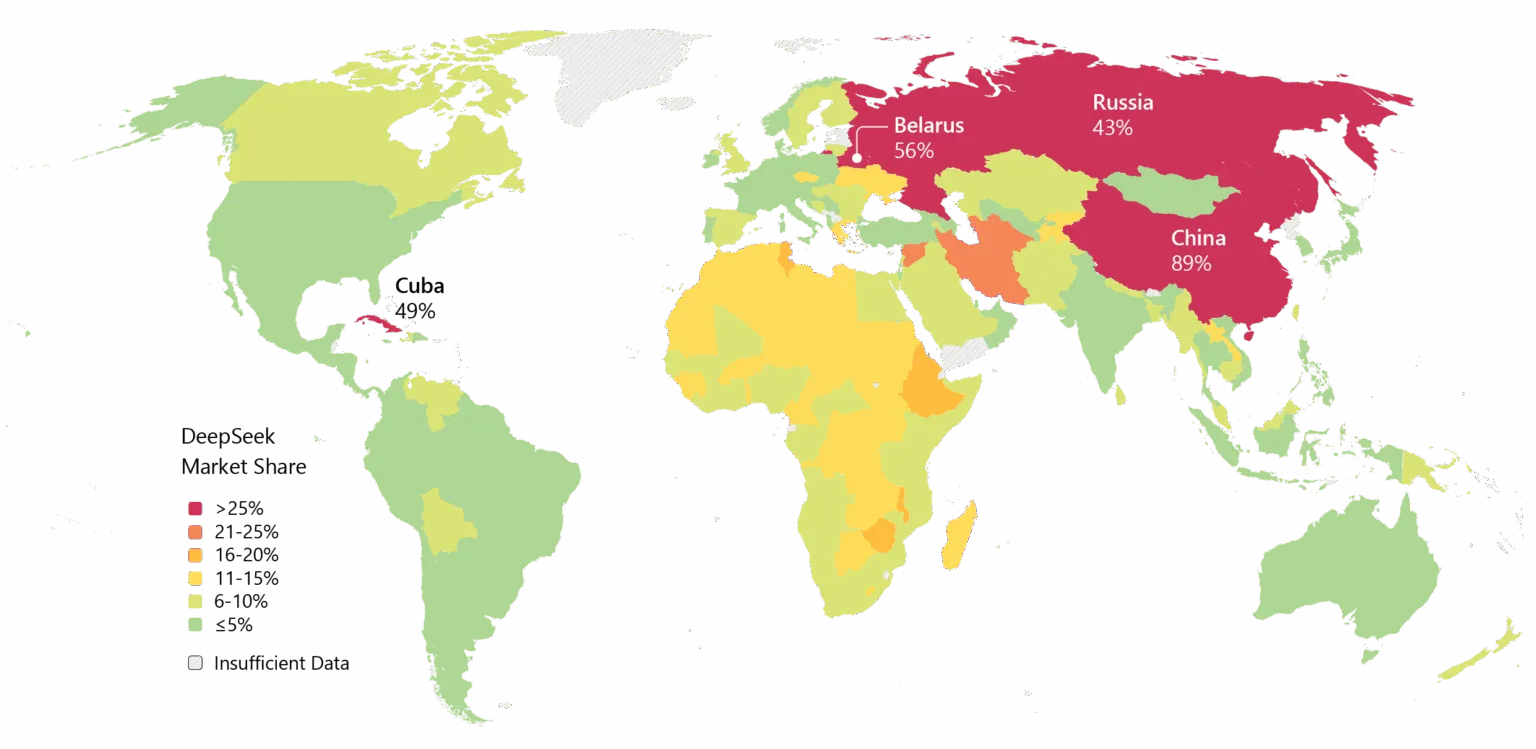

DeepSeek schleppt zudem Altlasten mit sich. Datenschutzbedenken verfolgen das Unternehmen, einige Regierungen haben die DeepSeek-eigene App verboten. Die Verbindungen zu China und Fragen zur Zensur in den Modellen sorgen für geopolitische Spannungen in technischen Debatten.

Dennoch ist der Auftrieb unübersehbar. DeepSeek ist in Asien weit verbreitet, und wenn V4 seine Coding-Versprechen einhält, könnte eine Übernahme durch Unternehmen im Westen folgen.

Bild: Microsoft

Es ist auch eine Frage des Timings. Laut hatte DeepSeek ursprünglich geplant, sein R2-Modell im Mai 2025 zu veröffentlichen, zog den Launch jedoch hinaus, nachdem Gründer Liang mit der Performance unzufrieden war. Nun, da V4 offenbar auf Februar und R2 potenziell auf August abzielt, bewegt sich das Unternehmen mit einer Geschwindigkeit, die auf Dringlichkeit – oder Selbstvertrauen – hindeutet. Vielleicht beides.

Bild: DeepSeek

Bild: DeepSeek  Bild: DeepSeek

Bild: DeepSeek  Bild: Microsoft

Bild: Microsoft