Nvidia lanza la nueva generación de la plataforma Rubin, con un costo de inferencia 10 veces menor que Blackwell y planea comenzar los envíos en la segunda mitad del año.

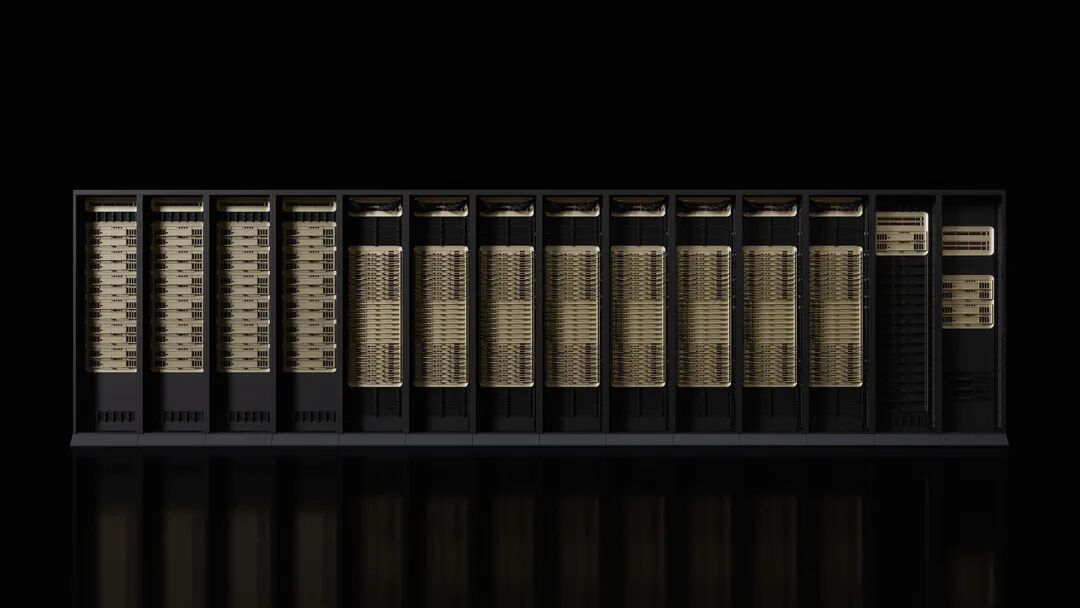

NVIDIA presentó en la feria CES su nueva generación de la plataforma Rubin AI, marcando la continuidad de su ritmo anual de innovación en el sector de chips de inteligencia artificial (IA). La plataforma, que integra seis nuevos chips, ofrece grandes avances en eficiencia de entrenamiento y costes de inferencia, y se entregará a los primeros clientes en la segunda mitad de 2026.

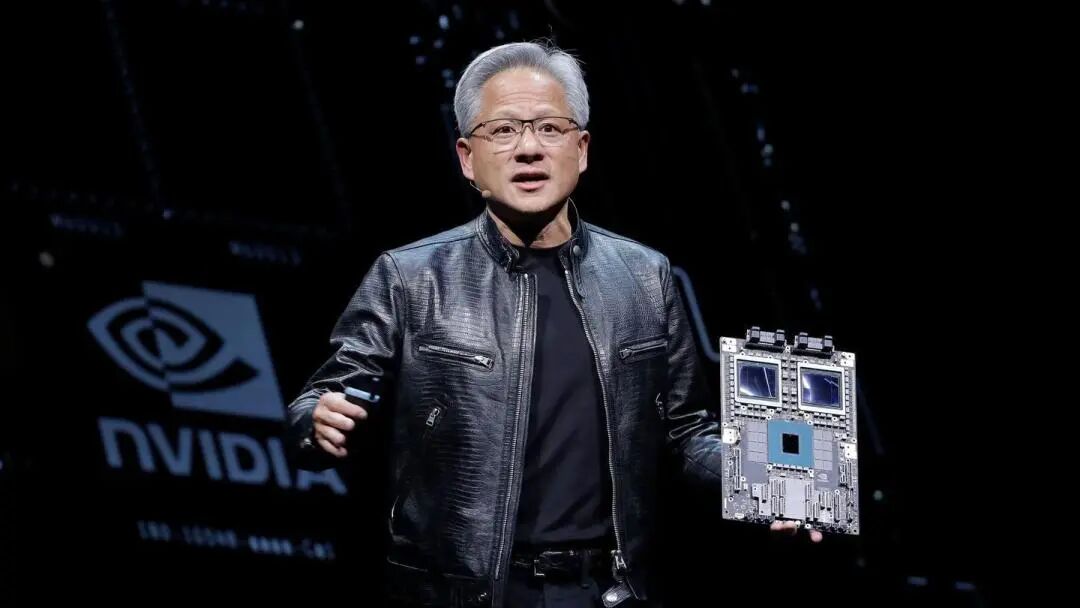

El lunes 5, hora del este de EE.UU., Jensen Huang, CEO de NVIDIA, declaró en Las Vegas que los seis chips Rubin ya han sido devueltos por los socios manufactureros y han superado algunas pruebas clave, avanzando conforme a lo previsto. Señaló que "la carrera de la IA ha comenzado, todos están esforzándose por alcanzar el siguiente nivel". NVIDIA enfatizó que los sistemas basados en Rubin tendrán costes operativos inferiores a los de la versión Blackwell, ya que logran los mismos resultados con menos componentes.

Microsoft y otros grandes proveedores de computación en la nube serán de los primeros clientes en implementar el nuevo hardware en la segunda mitad del año. La próxima generación de la superfábrica de IA Fairwater de Microsoft estará equipada con el sistema a nivel de rack NVIDIA Vera Rubin NVL72, escalable hasta cientos de miles de superchips NVIDIA Vera Rubin. CoreWeave también será uno de los primeros proveedores en ofrecer sistemas Rubin.

El lanzamiento de esta plataforma coincide con la preocupación de algunos analistas de Wall Street sobre el aumento de la competencia que enfrenta NVIDIA y las dudas acerca de si el gasto en el sector IA puede mantenerse al ritmo actual. Sin embargo, NVIDIA mantiene previsiones optimistas a largo plazo, estimando un mercado total de varios billones de dólares.

Mejoras de rendimiento orientadas a la nueva generación de IA

Según el comunicado de NVIDIA, el rendimiento de entrenamiento de la plataforma Rubin es 3,5 veces superior al de la generación anterior Blackwell, mientras que el rendimiento ejecutando software de IA se multiplica por 5. Comparada con Blackwell, Rubin puede reducir hasta 10 veces el coste de generación de tokens de inferencia, y disminuir por 4 la cantidad de GPU necesarias para entrenar modelos de expertos mixtos (MoE).

La nueva plataforma está equipada con la CPU Vera de 88 núcleos, cuyo rendimiento duplica al de los productos que reemplaza. Esta CPU está diseñada específicamente para inferencia de agentes y es el procesador más eficiente energéticamente para fábricas de IA a gran escala, utilizando 88 núcleos Olympus personalizados, compatibilidad total con Armv9.2 y conectividad NVLink-C2C ultrarrápida.

La GPU Rubin incorpora la tercera generación del motor Transformer, con aceleración por hardware para compresión adaptativa y una capacidad de cálculo NVFP4 de 50 petaflops dedicada a la inferencia de IA. Cada GPU proporciona un ancho de banda de 3,6TB/s, mientras que el rack Vera Rubin NVL72 suministra hasta 260TB/s.

Avances satisfactorios en las pruebas de chips

Jensen Huang reveló que los seis chips Rubin han sido devueltos por los socios manufactureros y han superado pruebas clave que demuestran que pueden desplegarse según lo previsto. Esta declaración reafirma la posición de liderazgo de NVIDIA como fabricante principal de aceleradores de IA.

La plataforma incluye cinco tecnologías innovadoras: la sexta generación de NVLink, el motor Transformer, computación confidencial, el motor RAS y la CPU Vera. La tercera generación de computación confidencial convierte a Vera Rubin NVL72 en la primera plataforma a nivel de rack que ofrece protección de datos en dominios de CPU, GPU y NVLink.

La segunda generación del motor RAS abarca GPU, CPU y NVLink, proporcionando monitorización en tiempo real, tolerancia a fallos y mantenimiento proactivo para maximizar la productividad del sistema. El rack utiliza un diseño modular sin bandejas de cables, permitiendo un ensamblaje y mantenimiento 18 veces más rápido que Blackwell.

Amplio apoyo del ecosistema

NVIDIA indicó que Amazon AWS, Google Cloud, Microsoft y Oracle Cloud serán los primeros en implementar instancias basadas en Vera Rubin en 2026, seguidos por socios de la nube como CoreWeave, Lambda, Nebius y Nscale.

Sam Altman, CEO de OpenAI, declaró: “La inteligencia se expande con el cómputo. A medida que aumentamos la computación, los modelos se vuelven más poderosos, resuelven problemas más complejos y tienen mayor impacto en las personas. La plataforma Rubin de NVIDIA nos ayuda a continuar impulsando este progreso”.

Dario Amodei, cofundador y CEO de Anthropic, señaló que "la mejora en la eficiencia de la plataforma Rubin de NVIDIA representa un avance en infraestructura que hace posible lograr memorias más largas, mejor razonamiento y salidas más confiables".

Mark Zuckerberg, CEO de Meta, afirmó que la "plataforma Rubin de NVIDIA tiene el potencial de ofrecer un cambio radical en rendimiento y eficiencia, algo necesario para desplegar los modelos más avanzados a miles de millones de personas".

NVIDIA también señaló que Cisco, Dell, Hewlett Packard Enterprise, Lenovo y Supermicro lanzarán varios servidores basados en productos Rubin. Laboratorios de IA como Anthropic, Cohere, Meta, Mistral AI, OpenAI y xAI esperan utilizar la plataforma Rubin para entrenar modelos aún más grandes y potentes.

Detalles del producto revelados por adelantado

Según los comentarios, este año NVIDIA ha revelado detalles de sus nuevos productos antes que en años anteriores, como parte de su estrategia para mantener la dependencia del sector en su hardware. Normalmente, NVIDIA detalla sus productos en profundidad en el evento GTC celebrado cada primavera en San José, California.

Para Jensen Huang, CES es una parada más en su maratón de apariciones públicas. En estos eventos anuncia productos, alianzas e inversiones, todo con el objetivo de impulsar el despliegue de sistemas de IA.

El nuevo hardware de NVIDIA también incluye componentes de red y conectividad que formarán parte de la supercomputadora DGX SuperPod, aunque también podrán adquirirse como productos independientes de manera más modular. Estas mejoras de rendimiento son esenciales, ya que la IA se ha orientado hacia redes de modelos más especializadas, no solo filtrando grandes volúmenes de datos de entrada sino también resolviendo problemas específicos mediante procesos en múltiples etapas.

NVIDIA está impulsando aplicaciones de IA en todos los sectores de la economía, incluyendo robótica, atención sanitaria e industria pesada. Como parte de este esfuerzo, la empresa ha anunciado una serie de herramientas diseñadas para acelerar el desarrollo de vehículos autónomos y robots. Actualmente, la mayoría del gasto en computación basada en NVIDIA proviene del presupuesto de capital de unos pocos clientes, incluidos Microsoft, Google Cloud de Alphabet y AWS de Amazon.

Disclaimer: The content of this article solely reflects the author's opinion and does not represent the platform in any capacity. This article is not intended to serve as a reference for making investment decisions.

You may also like

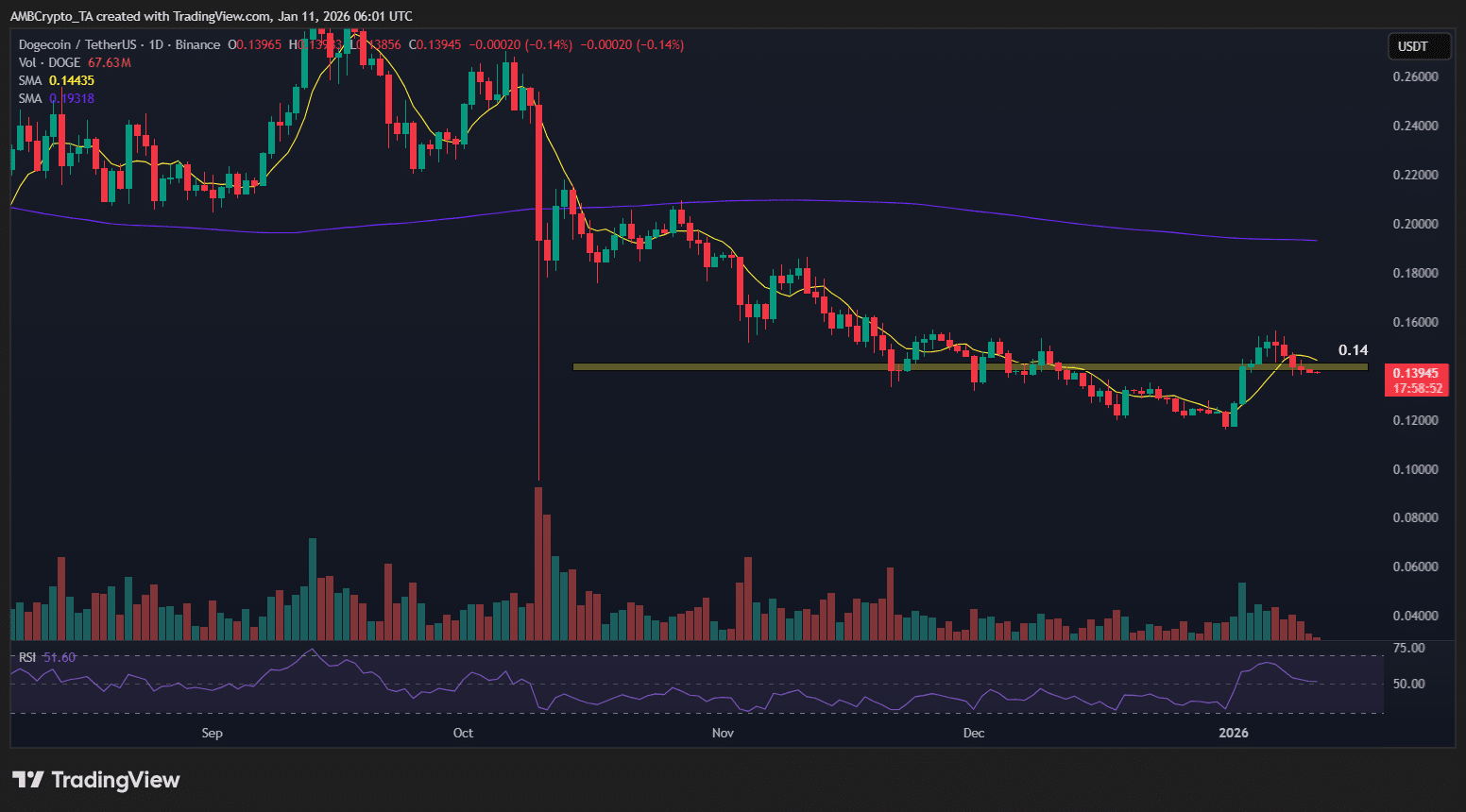

El entusiasmo por el ETF de Dogecoin se desvanece: ¿deberían los traders de DOGE prepararse para $0.12?

Transferencias encubiertas de criptomonedas de Irán eluden sanciones

Dan Ives: Las enormes inversiones en IA marcan solo el comienzo de la ‘Cuarta Revolución Industrial’