Nvidia lanza la nueva generación de la plataforma Rubin, el costo de inferencia es 10 veces menor que Blackwell y planea comenzar los envíos en la segunda mitad del año.

Nvidia presentó la nueva generación de la plataforma Rubin AI en la feria CES, marcando su ritmo anual de actualizaciones en el sector de chips de inteligencia artificial (IA). Esta plataforma, gracias a la integración de seis nuevos chips, logra avances significativos en costes de inferencia y eficiencia de entrenamiento, y se entregará a los primeros clientes en la segunda mitad de 2026.

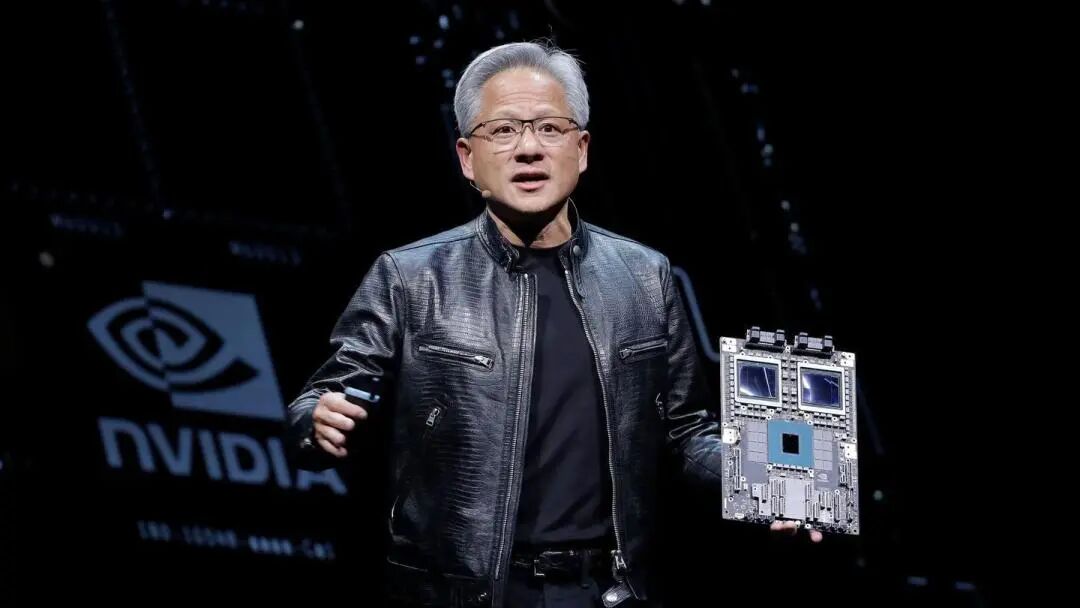

El lunes 5, hora del este de EE.UU., el CEO de Nvidia, Jensen Huang, declaró en Las Vegas que los seis chips Rubin han regresado de sus socios fabricantes y han superado algunas pruebas clave, avanzando según lo previsto. Señaló que "la competencia en IA ya comenzó, todos están esforzándose por alcanzar el siguiente nivel". Nvidia hizo hincapié en que los sistemas basados en Rubin tendrán menores costes operativos que la versión Blackwell, ya que logran los mismos resultados con menos componentes.

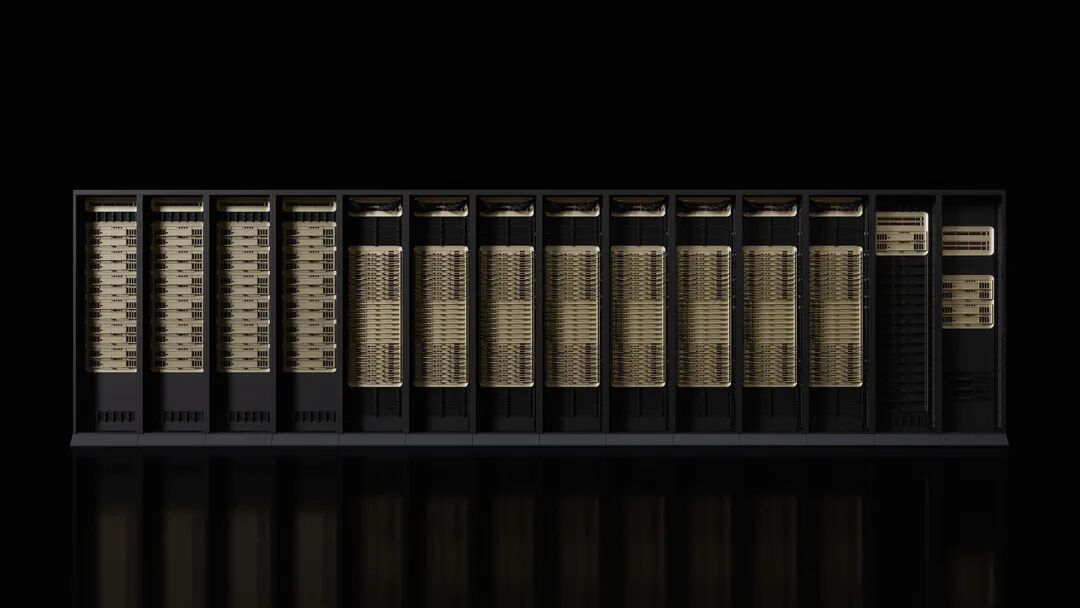

Microsoft y otros grandes proveedores de computación en la nube serán los primeros clientes en desplegar el nuevo hardware en la segunda mitad del año. La próxima generación de la superfábrica de IA Fairwater de Microsoft estará equipada con el sistema a nivel rack Nvidia Vera Rubin NVL72, que puede escalarse hasta cientos de miles de superchips Nvidia Vera Rubin. CoreWeave también será uno de los primeros proveedores en ofrecer sistemas Rubin.

El lanzamiento de esta plataforma coincide con la preocupación de algunos sectores de Wall Street por la creciente competencia que enfrenta Nvidia, así como dudas sobre si el gasto en el campo de la IA podrá mantener el ritmo actual. Sin embargo, Nvidia mantiene un pronóstico alcista a largo plazo y estima que el tamaño total del mercado podría alcanzar varios billones de dólares.

Mejoras de rendimiento apuntan a una nueva generación de IA

Según el anuncio de Nvidia, el rendimiento de entrenamiento de la plataforma Rubin es 3,5 veces superior al de la generación anterior Blackwell, y el rendimiento al ejecutar software de IA aumenta en 5 veces. En comparación con Blackwell, Rubin puede reducir hasta 10 veces el coste de generación de tokens de inferencia y disminuir en 4 veces la cantidad de GPU necesarias para entrenar modelos mixtos de expertos (MoE).

La nueva plataforma cuenta con el CPU Vera de 88 núcleos, cuyo rendimiento es el doble que el de los productos a los que reemplaza. Este CPU está diseñado específicamente para la inferencia de agentes y es el procesador de mayor eficiencia energética en grandes fábricas de IA, incorporando 88 núcleos Olympus personalizados, compatibilidad total con Armv9.2 y una conexión ultrarrápida NVLink-C2C.

El GPU Rubin incorpora la tercera generación del motor Transformer, con funciones de compresión adaptativa acelerada por hardware, y puede ofrecer 50 petaflops de capacidad de cómputo NVFP4 para inferencia de IA. Cada GPU proporciona un ancho de banda de 3,6TB/s, mientras que el rack Vera Rubin NVL72 ofrece 260TB/s de ancho de banda.

Avances favorables en las pruebas de chips

Jensen Huang reveló que los seis chips Rubin han regresado de los socios fabricantes y han superado las pruebas clave que demuestran que pueden desplegarse según lo previsto. Esta declaración resalta que Nvidia mantiene su posición de liderazgo como fabricante de aceleradores de IA.

La plataforma incluye cinco tecnologías innovadoras: la sexta generación de tecnología de interconexión NVLink, el motor Transformer, computación confidencial, el motor RAS y el CPU Vera. La tercera generación de tecnología de computación confidencial convierte al Vera Rubin NVL72 en la primera plataforma a nivel rack que proporciona protección de datos segura entre CPU, GPU y dominios NVLink.

La segunda generación del motor RAS abarca GPU, CPU y NVLink, y ofrece funciones de monitoreo de salud en tiempo real, tolerancia a fallas y mantenimiento proactivo para maximizar la productividad del sistema. El rack presenta un diseño modular y sin bandejas de cables, permitiendo una velocidad de ensamblaje y mantenimiento 18 veces superior a la de Blackwell.

Amplio soporte del ecosistema

Nvidia afirmó que Amazon AWS, Google Cloud, Microsoft y Oracle Cloud serán los primeros en desplegar instancias basadas en Vera Rubin en 2026, seguidos por socios en la nube como CoreWeave, Lambda, Nebius y Nscale.

El CEO de OpenAI, Sam Altman, declaró: “La inteligencia se expande con la computación. A medida que agregamos más capacidad de cómputo, los modelos se vuelven más poderosos, pueden resolver problemas más difíciles y generan un mayor impacto en las personas. La plataforma Rubin de Nvidia nos ayuda a seguir ampliando este progreso”.

Dario Amodei, cofundador y CEO de Anthropic, afirmó que las mejoras de eficiencia de la plataforma Rubin de Nvidia representan un avance en la infraestructura que permite mayor memoria, mejor razonamiento y resultados más fiables.

El CEO de Meta, Mark Zuckerberg, señaló que la “plataforma Rubin de Nvidia promete cambios radicales en rendimiento y eficiencia, lo cual es esencial para poner los modelos más avanzados en manos de miles de millones de personas”.

Nvidia también informó que Cisco, Dell, Hewlett Packard Enterprise, Lenovo y Supermicro planean lanzar distintos tipos de servidores basados en productos Rubin. Laboratorios de IA como Anthropic, Cohere, Meta, Mistral AI, OpenAI y xAI esperan utilizar la plataforma Rubin para entrenar modelos más grandes y potentes.

Detalles de producto anunciados con antelación

Según los comentarios, Nvidia ha revelado los detalles de sus nuevos productos antes que en años anteriores, como una forma de mantener la dependencia de la industria de su hardware. Normalmente, Nvidia profundizaba en los detalles de sus productos durante el evento GTC de primavera en San José, California.

Para Jensen Huang, el CES es solo otra parada en su maratón de apariciones en eventos. En cada uno de ellos, presenta productos, colaboraciones e inversiones, con el objetivo de impulsar el despliegue de sistemas de IA.

El nuevo hardware presentado por Nvidia también incluye componentes de red y conectividad que formarán parte de la supercomputadora DGX SuperPod, aunque también estarán disponibles como productos modulares individuales para los clientes. Esta mejora de rendimiento es esencial, ya que la IA se está orientando hacia redes de modelos más especializadas, que no solo deben filtrar grandes volúmenes de datos de entrada, sino también resolver problemas específicos a través de procesos en múltiples etapas.

Nvidia está impulsando aplicaciones de IA en toda la economía, incluyendo robótica, salud e industria pesada. Como parte de este esfuerzo, la empresa anunció una serie de herramientas diseñadas para acelerar el desarrollo de vehículos autónomos y robots. Actualmente, la mayor parte del gasto en computación basada en Nvidia proviene de los presupuestos de gastos de capital de unos pocos clientes, incluidos Microsoft, Google Cloud de Alphabet y AWS de Amazon.

Descargo de responsabilidad: El contenido de este artículo refleja únicamente la opinión del autor y no representa en modo alguno a la plataforma. Este artículo no se pretende servir de referencia para tomar decisiones de inversión.

También te puede gustar

El DOJ no vende Samourai Bitcoin, dice asesor – Kriptoworld.com

Macron planea invocar el mecanismo comercial de la UE ante el aumento de demandas de represalias

Intel apuesta por los fundamentos mientras sus rivales impulsan la inteligencia artificial en el mercado de laptops

TechCrunch Movilidad: “IA física” se convierte en la nueva palabra de moda