Nvidia merilis platform generasi terbaru Rubin, biaya inferensi turun 10 kali lipat dibanding Blackwell, pengiriman direncanakan pada paruh kedua tahun ini

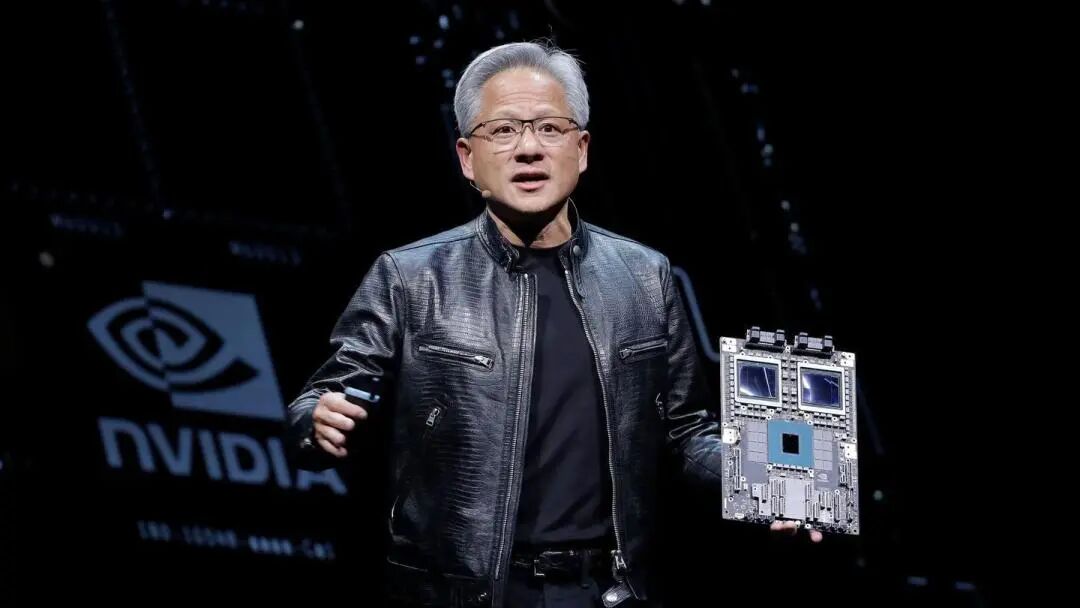

Nvidia meluncurkan platform Rubin AI generasi terbaru di pameran CES, menandai upaya perusahaan untuk mempertahankan ritme pembaruan tahunan di bidang chip kecerdasan buatan (AI). Platform ini, melalui desain terintegrasi enam chip baru, menghadirkan peningkatan besar dalam efisiensi biaya inferensi dan pelatihan, dan batch pertama akan dikirimkan ke pelanggan pada paruh kedua tahun 2026.

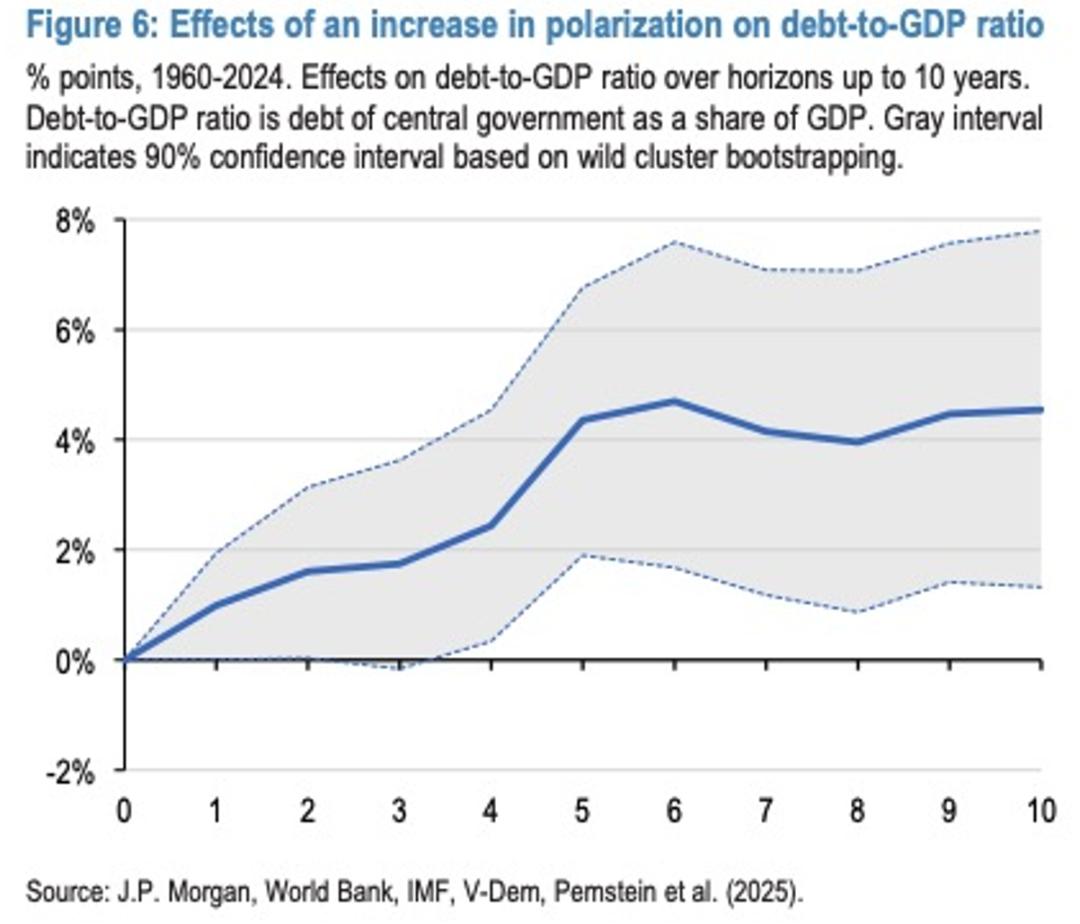

Pada hari Senin tanggal 5 waktu AS, CEO Nvidia Jensen Huang di Las Vegas menyatakan bahwa enam chip Rubin telah kembali dari mitra manufaktur dan telah melewati beberapa pengujian kunci, berjalan sesuai jadwal. Ia menekankan bahwa "perlombaan AI telah dimulai, semua orang berusaha mencapai level berikutnya". Nvidia menonjolkan bahwa sistem berbasis Rubin akan memiliki biaya operasional lebih rendah dibanding versi Blackwell, karena hasil yang sama dapat dicapai dengan komponen yang lebih sedikit.

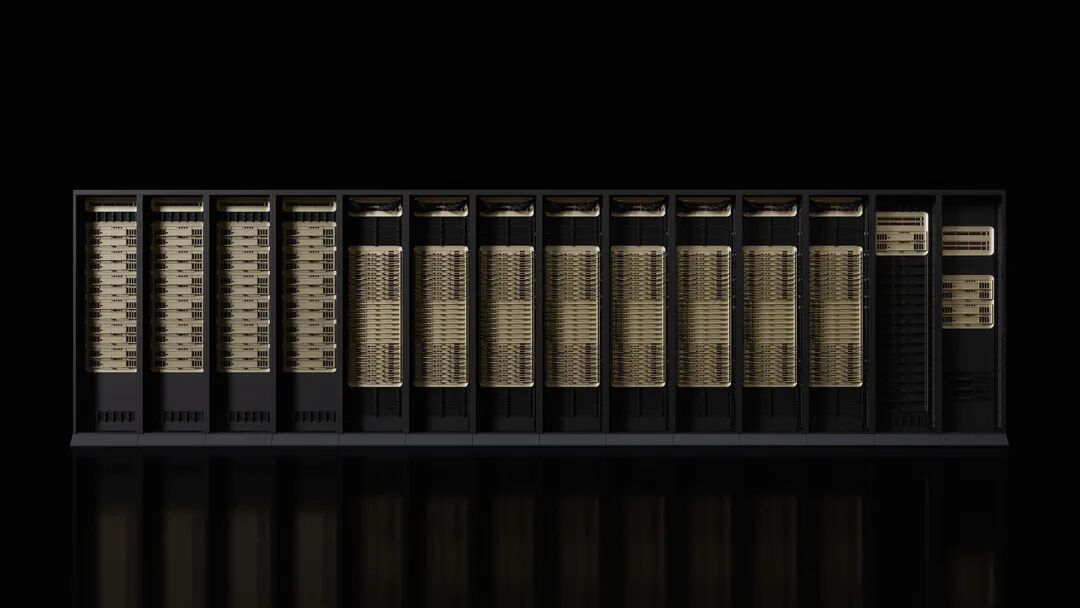

Microsoft dan penyedia layanan cloud besar lainnya akan menjadi pelanggan pertama yang mengadopsi perangkat keras baru ini pada paruh kedua tahun ini. Pabrik superkomputer AI Fairwater generasi berikutnya milik Microsoft akan dilengkapi dengan sistem rak Nvidia Vera Rubin NVL72, dengan skala yang dapat diperluas hingga ratusan ribu chip super Nvidia Vera Rubin. CoreWeave juga akan menjadi salah satu pemasok pertama yang menyediakan sistem Rubin.

Peluncuran platform ini bertepatan dengan kekhawatiran sebagian pelaku Wall Street bahwa Nvidia menghadapi persaingan yang semakin ketat dan meragukan apakah pengeluaran di bidang AI dapat dipertahankan pada kecepatan saat ini. Namun, Nvidia tetap optimis untuk jangka panjang, memperkirakan total pasar dapat mencapai puluhan triliun dolar AS.

Peningkatan Performa Menargetkan Kebutuhan AI Generasi Baru

Menurut pengumuman Nvidia, performa pelatihan platform Rubin adalah 3,5 kali lipat dari generasi sebelumnya, Blackwell, sedangkan performa menjalankan perangkat lunak AI meningkat 5 kali lipat. Dibandingkan dengan platform Blackwell, Rubin dapat menurunkan biaya pembuatan token inferensi hingga 10 kali lipat, dan jumlah GPU yang dibutuhkan untuk melatih model ahli campuran (MoE) dikurangi 4 kali lipat.

Platform baru ini dilengkapi dengan CPU Vera yang memiliki 88 inti, dengan performa dua kali lipat dari produk penggantinya. CPU ini dirancang khusus untuk inferensi agen, merupakan prosesor paling efisien untuk pabrik AI skala besar, menggunakan 88 inti Olympus yang dikustomisasi, kompatibel penuh dengan Armv9.2, dan koneksi NVLink-C2C berkecepatan sangat tinggi.

GPU Rubin dilengkapi dengan mesin Transformer generasi ketiga, memiliki fitur kompresi adaptif yang dipercepat perangkat keras, dapat memberikan kemampuan komputasi NVFP4 sebesar 50 petaflops untuk inferensi AI. Setiap GPU menyediakan bandwidth 3,6TB/s, sedangkan rak Vera Rubin NVL72 menyediakan bandwidth 260TB/s.

Kemajuan Pengujian Chip Berjalan Lancar

Jensen Huang mengungkapkan bahwa seluruh enam chip Rubin telah kembali dari mitra manufaktur dan telah melewati pengujian kunci yang menunjukkan dapat dikerahkan sesuai rencana. Pernyataan ini menunjukkan bahwa Nvidia mempertahankan posisinya sebagai produsen akselerator AI terdepan.

Platform ini mencakup lima teknologi inovatif utama: teknologi interkoneksi NVLink generasi keenam, mesin Transformer, komputasi rahasia, mesin RAS, dan CPU Vera. Di antaranya, teknologi komputasi rahasia generasi ketiga menjadikan Vera Rubin NVL72 sebagai platform rak pertama yang memberikan perlindungan keamanan data lintas CPU, GPU, dan domain NVLink.

Mesin RAS generasi kedua mencakup GPU, CPU, dan NVLink, menyediakan pemantauan kesehatan secara real-time, toleransi kesalahan, dan pemeliharaan proaktif untuk memaksimalkan produktivitas sistem. Rak menggunakan desain modular tanpa tray kabel, sehingga perakitan dan pemeliharaannya 18 kali lebih cepat daripada Blackwell.

Dukungan Ekosistem yang Luas

Nvidia menyatakan bahwa Amazon AWS, Google Cloud, Microsoft, dan Oracle Cloud akan menjadi yang pertama mengadopsi instans berbasis Vera Rubin pada tahun 2026, dengan mitra cloud seperti CoreWeave, Lambda, Nebius, dan Nscale juga akan mengikuti.

CEO OpenAI Sam Altman menyatakan: "Kecerdasan berkembang seiring dengan peningkatan komputasi. Ketika kita menambah lebih banyak komputasi, model menjadi lebih kuat, dapat menyelesaikan masalah yang lebih sulit, dan membawa pengaruh lebih besar bagi masyarakat. Platform Rubin Nvidia membantu kami terus memperluas kemajuan ini."

Pendiri dan CEO Anthropic, Dario Amodei, mengatakan bahwa “peningkatan efisiensi platform Rubin Nvidia merupakan kemajuan infrastruktur yang memungkinkan memori lebih panjang, inferensi lebih baik, dan output yang lebih andal”.

CEO Meta Mark Zuckerberg menyatakan, “Platform Rubin Nvidia diharapkan membawa perubahan besar dalam performa dan efisiensi, yang dibutuhkan untuk menerapkan model mutakhir kepada miliaran orang.”

Nvidia juga menyebutkan bahwa Cisco, Dell, Hewlett Packard Enterprise, Lenovo, dan Supermicro diperkirakan akan meluncurkan berbagai server berbasis produk Rubin. Laboratorium AI seperti Anthropic, Cohere, Meta, Mistral AI, OpenAI, dan xAI menantikan pemanfaatan platform Rubin untuk melatih model yang lebih besar dan lebih kuat.

Rincian Produk Diumumkan Lebih Awal

Komentar menyebutkan, Nvidia tahun ini mengungkap rincian produk baru lebih awal dari biasanya sebagai salah satu upaya perusahaan agar industri tetap bergantung pada perangkat kerasnya. Sebab, Nvidia biasanya memaparkan rincian produk secara mendalam di ajang GTC yang digelar setiap musim semi di San Jose, California.

Bagi Jensen Huang, CES hanyalah salah satu dari rangkaian maraton kehadiran di berbagai acara. Ia mengumumkan produk, kerja sama, dan investasi di berbagai acara, semuanya bertujuan untuk mendorong adopsi sistem AI.

Perangkat keras baru yang diumumkan Nvidia juga mencakup komponen jaringan dan konektivitas, yang akan menjadi bagian dari superkomputer DGX SuperPod, namun juga dapat digunakan sebagai produk terpisah secara modular oleh pelanggan. Peningkatan performa ini diperlukan karena AI telah beralih ke jaringan model yang lebih khusus, yang tidak hanya harus memfilter input dalam jumlah besar, tetapi juga memecahkan masalah spesifik melalui proses bertahap.

Nvidia sedang mendorong penerapan AI di seluruh sektor ekonomi, termasuk robotika, layanan kesehatan, dan industri berat. Sebagai bagian dari upaya ini, Nvidia mengumumkan serangkaian alat untuk mempercepat pengembangan mobil otonom dan robot. Saat ini, sebagian besar pengeluaran komputasi berbasis Nvidia berasal dari anggaran belanja modal segelintir pelanggan besar, termasuk Microsoft, Google Cloud yang dimiliki Alphabet, dan AWS yang dimiliki Amazon.

Disclaimer: Konten pada artikel ini hanya merefleksikan opini penulis dan tidak mewakili platform ini dengan kapasitas apa pun. Artikel ini tidak dimaksudkan sebagai referensi untuk membuat keputusan investasi.

Kamu mungkin juga menyukai

Setiap orang akan memiliki teman AI sendiri dalam lima tahun ke depan, kata eksekutif Microsoft

Perjalanan Bitcoin di Akhir Pekan Memicu Tren Pasar Baru