O perigo oculto da IA: como ferramentas sobrecarregadas estão desacelerando os LLMs

- Os servidores do Model Context Protocol (MCP) permitem que LLMs integrem ferramentas externas, mas enfrentam riscos de uso indevido e degradação de desempenho devido à sobrecarga das janelas de contexto. - O registro excessivo de ferramentas consome tokens, reduz o contexto utilizável e causa comportamentos não determinísticos devido ao tratamento inconsistente de prompts entre diferentes LLMs. - As preocupações de segurança incluem servidores MCP de terceiros não confiáveis, que possibilitam ataques à cadeia de suprimentos, em contraste com soluções controladas de primeira parte. - Plataformas como Northflank simplificam a implantação do MCP.

Os servidores Model Context Protocol (MCP) surgiram como uma infraestrutura crítica para desenvolvedores de IA, permitindo a integração de ferramentas externas em large language models (LLMs) para aprimorar a funcionalidade e eficiência. Esses servidores atuam como intermediários, permitindo que os LLMs aproveitem fontes de dados externas ou ferramentas sem exigir codificação direta ou integração de API. No entanto, discussões e análises recentes destacam preocupações crescentes em torno do uso indevido, instalação excessiva e potenciais riscos de segurança associados aos servidores MCP, especialmente quando implantados sem a devida supervisão.

Uma postagem recente no blog de Geoffrey Huntley, um engenheiro especializado em assistentes de codificação comerciais, explora as armadilhas de sobrecarregar a janela de contexto dos LLMs com muitas ferramentas MCP. Huntley estima que a remoção do limite de 128 ferramentas no Visual Studio Code em um evento recente gerou confusão generalizada entre os desenvolvedores, muitos dos quais instalaram inúmeros servidores MCP sem entender seu impacto. Ele enfatiza que cada ferramenta registrada na janela de contexto consome tokens, o que afeta diretamente o desempenho do modelo. Por exemplo, uma ferramenta que lista arquivos e diretórios consome aproximadamente 93 tokens. Com várias ferramentas adicionadas, a janela de contexto utilizável encolhe rapidamente, levando à degradação da qualidade de saída e a comportamentos imprevisíveis [1].

Esse problema é agravado pela falta de padronização nos prompts e descrições das ferramentas. Diferentes LLMs respondem aos prompts de maneiras distintas. Por exemplo, o GPT-5 torna-se hesitante ao encontrar letras maiúsculas, enquanto a Anthropic recomenda seu uso para ênfase. Essas variações podem levar a comportamentos inconsistentes das ferramentas e resultados não intencionais. Além disso, a ausência de controles de namespace nas ferramentas MCP aumenta o risco de conflitos quando várias ferramentas desempenham funções semelhantes. Se duas ferramentas para listar arquivos forem registradas, o LLM pode invocar uma delas de forma imprevisível, introduzindo não-determinismo no sistema [1].

A segurança é outra preocupação premente. Simon Willison, em sua postagem no blog sobre “The Lethal Trifecta”, destaca os perigos de permitir que agentes de IA interajam com dados privados, conteúdos não confiáveis e comunicação externa sem salvaguardas. Huntley expande esse ponto ao mencionar um recente ataque à cadeia de suprimentos na Amazon Q, onde um prompt malicioso fez com que o sistema excluísse recursos da AWS. Ele argumenta que a implantação de servidores MCP de terceiros, que carecem de supervisão, aumenta o risco de incidentes semelhantes. Em contraste, soluções de primeira parte, onde as empresas projetam suas próprias ferramentas e prompts, oferecem melhor controle sobre os riscos da cadeia de suprimentos [1].

Apesar dos desafios, a implantação de servidores MCP tornou-se cada vez mais simplificada. Plataformas como a Northflank agora oferecem serviços para construir, implantar e gerenciar servidores MCP como serviços seguros e autoescaláveis. Os usuários podem conteinerizar seu servidor MCP usando ferramentas como FastMCP e Starlette, e então implantá-lo com verificações automáticas de integridade e segredos de tempo de execução. Essa infraestrutura suporta tanto os protocolos HTTP/SSE quanto WebSocket, permitindo flexibilidade na forma como os clientes interagem com o servidor [2].

Olhando para o futuro, desenvolvedores e organizações são incentivados a adotar uma abordagem mais estratégica para o uso de servidores MCP. Huntley defende a limitação do número de ferramentas na janela de contexto para manter o desempenho e a segurança. Ele também recomenda implantar ferramentas apenas durante as etapas relevantes de um fluxo de trabalho — como usar o Jira MCP durante o planejamento e desativá-lo posteriormente — para minimizar riscos e otimizar a alocação de recursos. À medida que o ecossistema evolui, a padronização e as melhores práticas serão essenciais para garantir que os servidores MCP aprimorem, em vez de prejudicar, a produtividade impulsionada por IA [1].

Fonte:

Aviso Legal: o conteúdo deste artigo reflete exclusivamente a opinião do autor e não representa a plataforma. Este artigo não deve servir como referência para a tomada de decisões de investimento.

Talvez também goste

Especialista da Bitwise vê melhor relação risco-retorno desde a COVID

Do Kwon quer sentença mais leve após admitir culpa

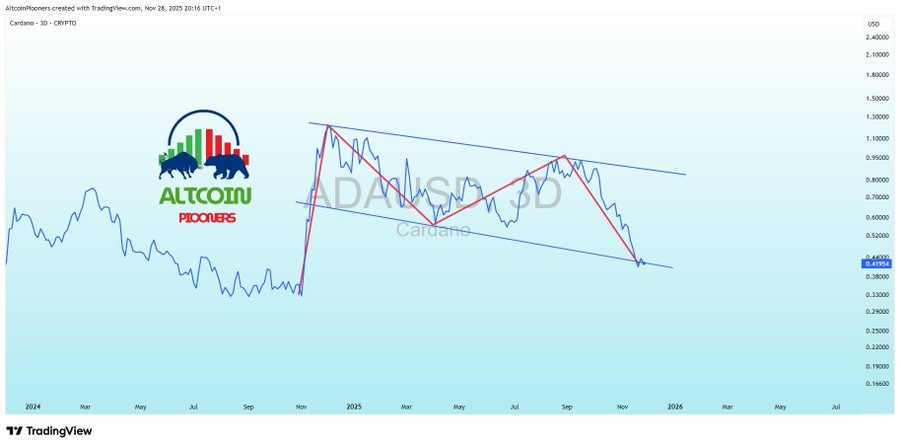

Análise de Preço da Cardano: ADA Aponta Reversão de Alta com Lançamento do Midnight se Aproximando