NVIDIAが新世代のRubinプラットフォームを発表��、推論コストがBlackwellより10倍低減、今年後半に出荷予定

NVIDIAはCES展示会で次世代Rubin AIプラットフォームを発表し、AI(人工知能)チップ分野での年次アップデートのリズムを維持しています。このプラットフォームは6つの新チップの統合設計により、推論コストとトレーニング効率が大幅に向上し、2026年下半期に初の顧客向けに納品される予定です。

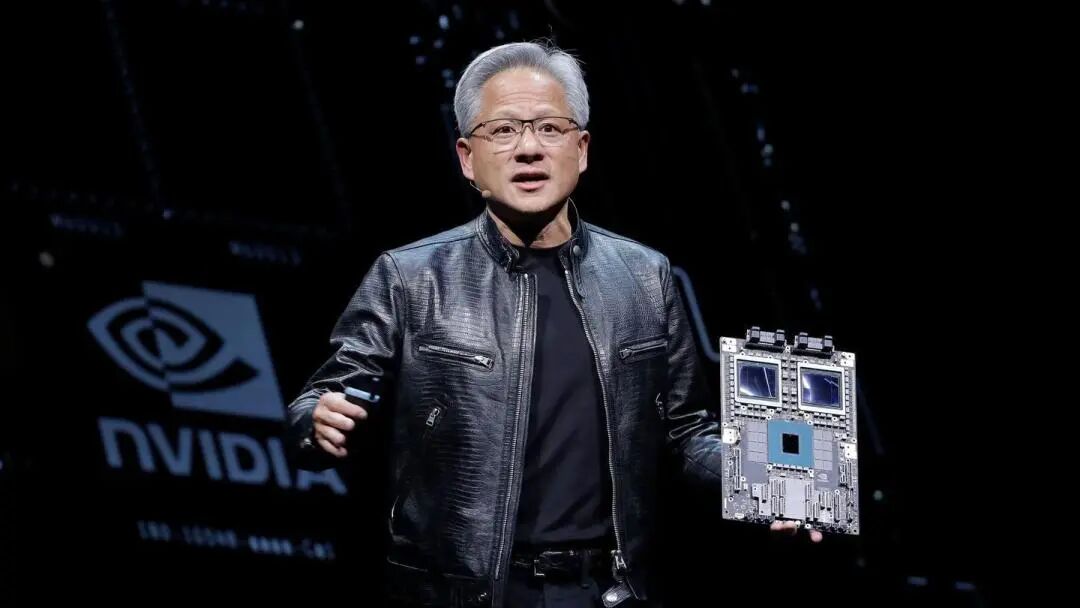

米国東部時間5日(月)、NVIDIAのCEOジェンスン・フアンはラスベガスで、6種類のRubinチップがパートナー企業の工場から戻り、主要なテストに合格し、計画通りに進行していると述べました。彼は「AI競争はすでに始まっており、誰もが次のレベルに到達しようと努力している」と強調しました。NVIDIAは、RubinベースのシステムはBlackwellバージョンよりも運用コストが低く、より少ないコンポーネントで同じ成果を得られるとしています。

Microsoftやその他の大規模クラウドコンピューティングプロバイダーが、下半期に新ハードウェアを最初に導入する顧客となります。Microsoftの次世代Fairwater AIスーパーファクトリーは、NVIDIA Vera Rubin NVL72ラックレベルシステムを搭載し、数十万個のNVIDIA Vera Rubinスーパー チップまで拡張可能です。CoreWeaveもRubinシステムを最初に提供するサプライヤーの一つです。

このプラットフォームの投入は、ウォール街の一部でNVIDIAが競争激化に直面し、AI分野の投資が現在のペースで維持できるか疑問視される中で行われました。しかしNVIDIAは長期的な強気見通しを維持し、総市場規模は数兆ドルに達すると見ています。

性能向上は次世代AI需要を見据えて

NVIDIAの発表によると、Rubinプラットフォームのトレーニング性能は前世代のBlackwellの3.5倍、AIソフトウェアの実行性能は5倍に向上しています。Blackwellプラットフォームと比較して、Rubinは推論トークン生成コストを最大10倍削減し、混合エキスパートモデル(MoE)のトレーニングに必要なGPU数を4分の1にします。

新プラットフォームに搭載されるVera CPUは88コアを持ち、同等製品の2倍の性能を誇ります。このCPUはエージェント推論専用に設計されており、大規模AIファクトリーで最もエネルギー効率の高いプロセッサーです。88のカスタムOlympusコア、完全なArmv9.2互換性、そして超高速NVLink-C2C接続を備えています。

Rubin GPUは第3世代Transformerエンジンを搭載し、ハードウェアアクセラレーションによるアダプティブ圧縮機能を備え、AI推論用に50ペタフロップスのNVFP4計算能力を提供します。各GPUは3.6TB/sの帯域幅を持ち、Vera Rubin NVL72ラックは260TB/sの帯域幅を実現します。

チップテストは順調に進行

ジェンスン・フアンは、全6種類のRubinチップが製造パートナーから返却され、計画通りに展開できることを示す重要なテストに合格したと明かしました。この発言は、NVIDIAがAIアクセラレータの主要メーカーとしての優位性を維持していることを示しています。

このプラットフォームは5つの革新的な技術を含みます:第6世代NVLinkインターコネクト技術、Transformerエンジン、機密コンピューティング、RASエンジン、そしてVera CPUです。第3世代の機密コンピューティング技術により、Vera Rubin NVL72はCPU、GPU、およびNVLinkドメイン全体でデータセキュリティを提供する最初のラックレベルプラットフォームとなります。

第2世代RASエンジンはGPU、CPU、NVLink全体にまたがり、リアルタイムのヘルスチェック、フォールトトレランス、アクティブメンテナンス機能を備え、システムの生産性を最大化します。ラックはモジュラー式でケーブルトレイがなく、Blackwellよりも18倍速く組み立て・メンテナンスが可能です。

広範なエコシステムサポート

NVIDIAは、AmazonのAWS、Google Cloud、Microsoft、Oracle Cloudなどが2026年にVera Rubinベースのインスタンスを最初に導入し、クラウドパートナーのCoreWeave、Lambda、Nebius、Nscaleも追随すると述べています。

OpenAIのCEOサム・アルトマンは次のように述べています。「知能は計算とともに拡大します。計算能力を増やすことで、モデルはより強力になり、より難しい課題を解決し、人々により大きなインパクトをもたらします。NVIDIA Rubinプラットフォームは、私たちがこの進歩を継続的に拡大するのを助けてくれます。」

Anthropic共同創設者兼CEOのダリオ・アモデイは、NVIDIA「Rubinプラットフォームの効率向上は、より長い記憶、より良い推論、より信頼性の高い出力を実現する基盤インフラの進歩を示している」と述べました。

MetaのCEOマーク・ザッカーバーグは、NVIDIAの「Rubinプラットフォームは性能と効率のステップチェンジをもたらす可能性があり、これは最先端モデルを数十億人に展開するために必要だ」と述べました。

NVIDIAはまた、Cisco、Dell、Hewlett Packard Enterprise、Lenovo、SupermicroがRubin製品ベースの各種サーバーを提供する見込みであると述べています。Anthropic、Cohere、Meta、Mistral AI、OpenAI、xAIなどのAI研究機関は、Rubinプラットフォームを使ってより大規模で強力なモデルのトレーニングを期待しています。

製品詳細の早期公開

コメントによれば、NVIDIAは今年、例年よりも早く新製品の詳細を公開しました。これは業界が同社のハードウェアに依存し続けるための取り組みの一つです。なぜなら、NVIDIAは通常、毎年春にカリフォルニア州サンノゼで開催されるGTCイベントで製品詳細を深く紹介しているからです。

ジェンスン・フアンにとって、CESはマラソンのようなイベント出席の一つに過ぎません。彼はさまざまなイベントで製品、提携、投資を発表し、いずれもAIシステム導入の勢いをつけることを目的としています。

NVIDIAが公開した新しいハードウェアには、ネットワークおよび接続コンポーネントも含まれており、DGX SuperPodスーパーコンピュータの一部となるほか、顧客がよりモジュール化された方法で単体製品として利用することも可能です。この性能向上は必要不可欠で、AIはより専門化したモデルネットワークへと進化しており、膨大な入力データをフィルタリングするだけでなく、多段階プロセスで特定の課題を解決する必要があります。

NVIDIAはロボティクス、医療、重工業を含む経済全体に向けたAIアプリケーションを推進しています。この取り組みの一環として、自動運転車やロボット開発を加速するためのツール群を発表しました。現在、NVIDIAベースのコンピュータへの投資の大部分は、Microsoft、Alphabet傘下のGoogle Cloud、Amazon傘下のAWSなど少数の顧客の資本支出予算から来ています。

免責事項:本記事の内容はあくまでも筆者の意見を反映したものであり、いかなる立場においても当プラットフォームを代表するものではありません。また、本記事は投資判断の参考となることを目的としたものではありません。

こちらもいかがですか?

Metaのメタバースへの野望がどこで失敗したのか

9,000億ドルの送金市場をターゲットにすることで、2026年に買うべき最良の暗号資産が生まれる可能性

ETHは停滞、Pepeは下落、Zero Knowledge Proofのステージ2コインバーンが7000倍の爆発の始まりとなる可能性!

暗号通貨愛好家がHYPE Coinの反発を目撃、主要なレジスタンス突破が迫る